V recenzi GeForce GTX Titan jsem se zmiňoval, že se nám povedlo kartu do testů získat celkem brzo díky tomu, že jsme celou akci spáchali dost narychlo a díky osobnímu předání se 100Mega Distribution jsme ušetřili jeden den na přepravě (respektive hned tři dny, protože při využití některého z přepravců by počítač cestoval přes víkend).

Jenže ještě předtím, než se 100Mega přihásila s nabídkou sestavy, jsme měli domluvenou i jinou GeForce u dalšího velkého distributora – eD' system Czech, a. s. Karta k nám odcházela ještě dříve, než dorazil HAL3000, ale tentokrát šla přes přepravce a cestovala přes víkend, takže dorazila až v pondělí.

Díky tomu se mi tu potkaly dvě karty a vedle běžné recenze jedné karty vám můžeme nabídnout i test dvou karet ve SLI.

Druhá karta pochází z dílen Gigabyte a stejně jako testovaný Zotac jde o referenční provedení, a to doslova – stejné jsou parametry, stejná je verze BIOSu, stejný je identifikátor výrobce, který karta hlásí třeba v GPUz – NVIDIA(10DE).

Samotnou GeForce GTX Titan už jsme probírali dost zevrubně a karta od Gigabyte se liší v podstatě jen příslušenstvím. V něm najdete kabel HDMI, napájecí redukce (ze dvou 4pinových diskových molexů na 6pin a ze dvou 4pin molexů na 8pin), redukce z DVI-I na analogový D-sub a médium s ovladači a manuál.

K luxusní kartě přidal Gigabyte kromě standardní výbavy i něco navíc – v krabici najdete tubus s podložkou GP-MP8000 (v obchodech ji pořídíte za nějakých 250 korun) a balíček žolíkových karet v plastové krabičce.

Testovací sestava

To by bylo v kostce vše, můžeme se vrhnout na testování. Základní deska, kterou máme v testovací sestavě, má sloty PCIe ×16 uspořádané tak, že při osazení dvou grafik do SLI zůstává mezi kartami volný prostor dvou slotů. Pomáhá to k lepšímu chlazení karet, pro nás to ale také znamená, že pokud budou osazené do desky se sloty blíže u sebe, bude zahřívání karet vyšší.

Jako testovací platforma posloužila základní deska Gigabyte X79-UD5 s BIOSem F10. Procesor je šestijádrový Core i7-3960X s TDP 130 W, který je přetaktovaný na 4,2 GHz při 1,36 V. Asistuje mu 16GB kit operačních paměti DDR3 od Kingstonu.

- základní deska: Gigabyte X79-UD5

- procesor: Core i7-3960X (deaktivovaný HTT, C1E, EIST), 4,2 GHz na 1,36 V

- chladič CPU: Noctua NH-D14

- paměti: 4× 4 GB Kingston DDR3 KHX2133C11D3K4/16GX

- zdroj: Enermax Revolution 85 ERV920EWT-00, 920 W

- pevný disk: Intel SSD 510 (250 GB)

- skříň: Gelid DarkForce

- operační systém: Windows 7 x64

Testy hlučnosti

Hlučnost grafických karet měřím samostatně na speciální sestavě, která vznikla jen kvůli tomuto účelu. Podrobnosti o ní najdete v článku Ze zákulisí: nové sestavy pro měření grafik a hlučnosti. Sestava je osazená SSD, o chlazení dvoujádrového Athlonu se stará chladič Noctua NH-C14, která během měření hlučnosti chladí procesor jen pasivně. Jediným aktivním zdrojem hluku u sestavy při měření je tak tichý zdroj Enermax s ventilátorem běžícím na přibližně 600 ot./min. Abych hluk jeho ventilátoru co nejvíc izoloval od grafické karty, je záměrně umístěný až za základní deskou.

Při měření na grafické kartě nastavím otáčky, které jsem zjistil ze zátěžových testů naměřených na herní sestavě a změřím samostatně hlučnost grafické karty. Protože je většina karet (hlavně bez zátěže) tišší než samotná testovací sestava pro měření výkonu, je to jediná možnost, jak se vyhnout zkreslení výsledků systémovými ventilátory a ostatními aktivními prvky chlazení.

Ovladače

Karty jsou otestovaná se ovladači GeForce 314.14 beta z webu Nvidie. Kromě testu dvou karet se SLI jsem přetestoval i referenční Radeon HD 7970 na ovladačích Catalyst 13.2 beta 7.

Karty pro srovnání

Ve srovnání najdete karty, které jste mohli vidět v nedávných recenzích na Extrahardware.cz. Na jakých ovladačích byla karta testovaná zjistíte z podrobnějších informací, které se zobrazí v rámečku v grafech po najetí na příslušný datový pruh.

Z konkurenčních produktů má k testovanému modelu nejblíže asi přetaktovaný model Sapphire HD 7970 GHz ed. se 6 GB paměti. Ten už bohužel dávno nemám, takže je nad mé možnosti přetestovat jej na nejnovějších ovladačích. Dá se předpokládat, že by u nich došlo k výraznému nárůstu výkonu v Battlefieldu, u ostatních her už není rozdíl dramatický. Výsledky testované se staršími s ovladači Catalyst 12.7 beta jsou kvůli tomu v grafech vybarvené jiným odstínem.

Aliens vs. Predator, Battlefield 3

Aliens vs. Predator

Scénu z úvodu hry jsme nově nahradili samostatným benchmarkem, který je na internetu k dispozici ke stažení zdarma. Běží v režimu DirectX 11 a je o poznání náročnější než náš původní test.

Pro snadnější testování existuje utilita AvP benchmark tool, tu stačí nastavit takto a spustit test:

Battlefield 3

Battlefield testuji s maximální úrovní detailů, výjimkou je pouze deaktivované vyhlazování MSAA, který kvůli náročnosti enginu zvládají rozumně jen nejvýkonnější karty. Vyhlazuje se tedy pouze pomocí FXAA. Testuje se 70 s dlouhý úsek po začátku druhé mise Operation Swordbreaker po vystoupení z transportéru.

Crysis Warhead, Crysis 2

Crysis Warhead

K otestování výkonu v Crysis: Warhead používám utilitu Framebuffer Crysis Warhead Benchmarking Tool 0.31. Aby bylo měření kompatibilní s ověřovaným (ranked) benchmarkem, nechávám volbu na mapě ambush a implicitním čase (v tomto případě noc). Používám rozhraní DirectX 10 a zkouším jak nastavení Gamer (hráč, odpovídá detailům high v původním Crysis), tak Enthusiast (very high). Beru výsledek druhého měření, kdy už je hra načtena v paměti. Měření jsou opakovatelná s minimální odchylkou.

Crysis 2

V prvních dvou grafech je v singleplayeru měřeno prvních 60 sekund z mapy Alien Vessel, ve druhém pak 105 s z mapy City Hall.

Hra má doinstalovaný patch s podporou DirectX 11 a hires pack textur. Detaily jsou nastavené na maximum.

Max Payne 3, Metro 2033

Max Payne 3

Také Max Payne 3 je testovaný stejnou metodikou jako ve srovnání výkonu grafických karet. Téměř všechna nastavení jsou na maximu, výjimkou je snížené rozlišení map pro stíny (s nejvyšší kvalitou stínů by nebylo možné měřit v rozlišení 2560 × 1600 bodů karty s 1 GB paměti). Z obdobného důvodu a také kvůli velkým nárokům na výkon karty je deaktivované náročnější vyhlazování MSAA, hrany jsou vyhlazované pouze pomocí FXAA..

Výkon měřím FRAPSem po dobu 38 sekund ve dvou náročných lokacích – na druhém checkpointu z páté kapitoly a na druhém checkpointu ze sedmé kapitoly.

Metro 2033

Testování v Metro 2033 doznalo oproti dřívější metodice jednu podstatnou změnu. Hru už netestuji ručně, ale pomocí vestavěného benchmarku.

Nastavení odpovídá nedávnému velkému srovnání 16 grafických karet.

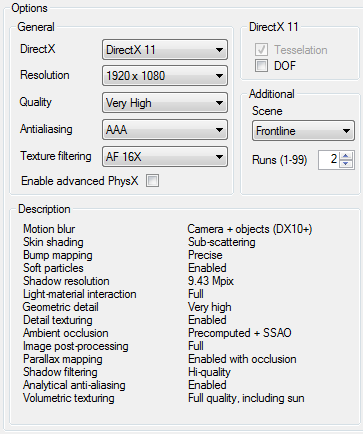

Testuji v nabízené lokaci Frontline. V Metro 2033 netestuji nejnáročnější nastavení, jak již psal ve velkém srovnání 16 karet Mirek, MSAA je spíše na škodu (ve hře rozmazává tak, jakoby šlo o nějaký postprocessing filtr a ne běžný multi-sampling) a tudíž používám pro změnu zase skoro neznatelné AAA. Vypnuta je výkon neskutečným způsobem žeroucí funkce DOF (Depth Of Field, hloubka ostrosti), jelikož to podle diskuzních fór nejspíše pro hratelné snímkové frekvence udělá většina lidí.

World in Conflict

World in Conflict

Testuji s upraveným profilem very high details. Navíc jsem zapínám water reflects clouds (voda odráží oblaka) a anizotropní filtrování navýšil na 16×. Používám vestavěný benchmark.

Spotřeba (příkon)

Měření spotřeby

Protože nás zajímají především rozdíly mezi jednotlivými kartami, pro zmenšení chyby měření a snížení vlivu procesoru jsou u sestavy deaktivované úsporné funkce procesoru (navíc přetaktovaného). To kdybyste se divili, proč se jinde dostávají k hodnotám kolem 60 W, zatímco naše sestava jde daleko přes 100 W. Samotná sestava bez grafické karty by měla mít bez zátěže spotřebu kolem 115 W.

Spotřeba dvou GeForce GTX Titan

Po spuštění zátěže vyskočila spotřeba na chvíli až na 639 W. Potom šla postupně dolů na průměrných 540 W (přesněji rychle poskakovala v rozmezí 527–554 W, u většiny karet je rozptyl v rozmezí pár wattů). Na tom je ještě více znát atypické chování regulace s GPU Boost 2.0.

Opět musím zdůraznit, že hodnoty spotřeby (ale i výkon) jsou po delší zátěži podstatně nižší, než jakých mohou karty dosahovat, pokud se méně zahřívají. Pokud pustíte ventilátory na grafikách ručně na maximum, zvládá chladič uchladit i vyšší frekvence, spotřeba se pohybovala kolem 620-650 W.

Zatímco obvykle po startu zátěže spotřeba roste, než se karta dostatečně prohřeje a vše ustálí, u GTX Titan to kvůli řízení turba podle teploty funguje jinak. Se spuštěním zátěže regulace nastaví vysoké takty. S vyšší teplotou ale automatika takty snižuje a s tím nastavuje i nižší napětí GPU. Spotřeba karty je při nižších taktech a napětí také výrazně nižší, takže při postupném zahřívání karty paradoxně klesá.

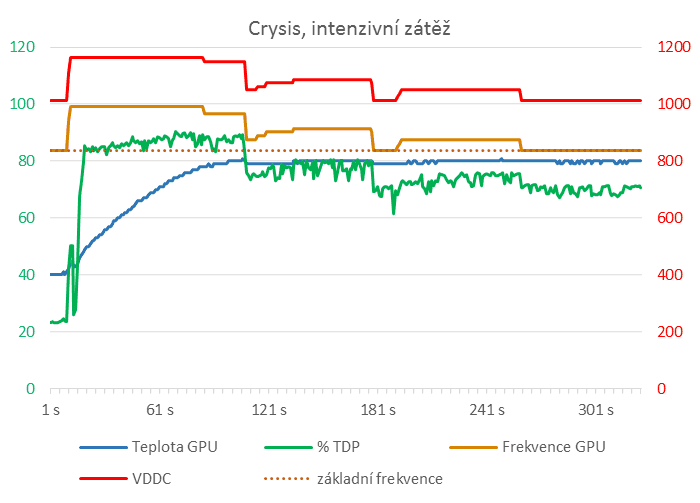

Log z jedné z karet jsem převedl do následujícího grafu. Levá osa platí pro teplotu a spotřebu tak, jak ji měří diagnostika karty [v % z celkového TDP], pravá je pro frekvenci GPU a odpovídá také mV pro napájecí napětí tak, jak jej ukazuje diagnostika v GPUz (1000 na ose je 1,0 V). Na začátku jádro běží na 990 MHz s napětím těsně pod 1,2, postupně ale klesá až na základní takt 837 MHz (tečkovaná čára) a napětí lehce nad 1 V. Spolu s tím jde dolů i spotřeba samotné karty (zelená čára) i přesto, že se teplota karty od zahřátí nemění a zůstává na ~80 °C.

U jedné ze dvou karet jsem narazil ještě na další věc. Při zátěži se dostal GPU Boost už na základní takty, pod které už GPU Boost nejde, pokud není moc zle (moc zle znamená, že teplota GPU přesáhne 95 °C). Místo dalšího snižování taktů už se tedy jen zvedala rychlost ventilátoru až na ~2900 ot./min, přičemž se teplota nakonec ustálila na 85 °C.

Také to znamená, že například s vodním chlazením by mohl být výkon karty (a spolu s tím i spotřeba) výrazně vyšší (pokud chladič zvládne udržet teploty pod 80 °C tak, aby GPU Boost držel vyšší takty).

Spotřeba v úsporném režimu monitoru

Tady Radeony vítězí zásluhou technologie ZeroCore, ve kterém by jejich spotřeba měla být nižší než 3 W. Záměrně říkám že měla, protože s přibývajícími kartami a při rozdílech mezi Radeony je zřejmé, že se všechny Radeony do deklarovaného 3W limitu v ZeroCore vejít nemohly.

Následuje spotřeba počítače při nečinnosti, kdy je zobrazená pracovní plocha systému. Tam je spotřeba karty o malinko vyšší, pohybujeme se ale na rozdílech v řádech jednotek Wattů, které jsou jen o málo větší než chyba měření.

V následujícím grafu je spotřeba sestavy v náročné statické scéně v Crysis. Grafické karty v ní dosahují o poznání vyšší spotřeby než při běžném hraní, snad se dá říci, že jde o maximální hodnoty, na které se ve hrách běžně vůbec dá dostat.

Nejde o jednu špičkovou hodnotu, kterou zaznamenal wattmetr, jak se to často pro usnadnění v testech měří, ale o průměrnou hodnotu zaznamenávanou zhruba po dobu jedné minuty po 10–30 minutách stejné zátěže, kdy se dostatečně prohřeje chladič karty i samotná sestava a teplota grafického jádra i spotřeba se ustálí.

Při běžném hraní, kde není grafické jádro tolik vytížené a karty se tak nezahřívají, bývají rozdíly menší. Obzvlášť to platí, když grafickou kartu brzdí procesor.

Zejména 28nm Radeonům příliš nesvědčí vyšší teploty, na které se karty v testovací scéně v Crysis zahřívají, počítejte s tím, že při běžném hraní, kde takovou scénou jen proběhnete, na tom budou ve srovnání s Geforce líp.

Některé karty už jsou bohužel rozebírané, takže už nemají původní pastu. Konkrétně jde o GeForce GTX 690, i v případě referenční HD 7970 musím ještě připomenout, že jde o tutéž kartu, se kterou jste se mohli setkat v recenzi Sapphire HD 7970, konkrétně referenční model přímo od AMD, který už bohužel prodělal nejednu rozborku a tak není v původní podobě, ale má na jádře nanesenou kvalitnější teplovodivou pastu Noctua NT-H1. Kvůli tomu je spotřeba karty i teploty o něco nižší než tomu bylo u karty nerozebírané, kterou jste dosud mohli vídat v grafech. Pořád jde ale o karty z prvních várek, které mohly mít horší jádra než později prodávané modely.

V dalším grafu je vypočtený poměr výkon/watt ze stejné scény. Číslo je to jen přibližné, vychází z odhadované spotřeby karty (tu jsem dostal odečtením spotřeby sestavy s jedním zatíženým jádrem od spotřeby celé sestavy) a vyjadřuje, kolik W si vyžádá jeden snímek za sekundu, lepší jsou menší hodnoty. Opět připomínám, že jde o situaci při intenzivním vytížení grafické karty náročnou scénou a v méně náročných situacích jsou rozdíly menší.

Teploty, otáčky ventilátoru, hlučnost

Teploty

Teploty bez zátěže měřím při okolní teplotě 25 °C v zakrytované testovací sestavě. Teplotu v zátěži odečítám po ustálení po 10–60 minutách zatížení grafické karty náročnou scénou v Crysis. Dosahovaná teplota je vyšší než při běžném hraní, jde o zátěž, na kterou se můžete dostat ve výjimečně náročných scénách a situacích. Do jisté míry supluje zátěžové testy jako je Furmark či MSI Kombustor, jen s tím rozdílem, že nejde o umělý test stavěný speciálně na abnormální vytížení grafického čipu, ale je přímo z praxe.

Pamatujte na to, že se u daného údaje spoléháme jen na to, co na sebe sama grafická karta požaluje a nikde není uvedeno, nakolik údaj z čidla odpovídá realitě. U komponent se běžně stává, že jádro hlásí nižší teplotu, než má vzduch, který jej chladí.

Proto nedoporučuji srovnávat teploty u různých modelů karet, rozumně porovnávat se dají snad jen karty se stejným grafickým čipem. Mezi jednotlivými modely už nezbývá než se spoléhat na to, že hodnota, kterou zobrazují diagnostické utility, odpovídá realitě a výrobce ji nějak nepřikrášlil.

Teploty GeForce GTX Titan

Nízká teplota bez zátěže při nízké hlučnosti je u novějších karet už takovým nepsaným standardem, dosažená hodnota je zcela v normě a není vykoupena hlukem chladiče.

Zatímco u jedné karty se teplota držela na 80 °C, se dvěma kartami ve SLI na tom byla jedna z grafik kvůli horšímu přístupu vzduchu hůře. Teplota stoupla na 85 °C, na což regulace nereagovala snížením taktů (protože karta běžela už na základních 837 MHz, ale zvýšila otáčky ventilátoru.

Otáčky ventilátoru

Protože ne všechny karty používají stejně koncipované chladiče a zejména stejně velké a stejně výkonné ventilátory, nemá samotné porovnávání otáček ventilátorů valný význam. Údaje v tomto grafu jsou pouze informativní na doplnění ke grafům hlučnosti.

Ještě dodám, že obecně jsou radiální (odstředivé) ventilátory s lopatkami po obvodu, které se běžně používají u výkonnějších referenčních karet, výrazně hlučnější než chladiče s axiálními ventilátory.

Karty s jedním ventilátorem bávají při stejných otáčkách tišší než karty se dvěma obdobnými ventilátory – důvodem nemusí být jen vyšší průtok vzduchu, ale i interference obou ventilátorů, kvůli níž mohou otáčky ventilátorů i hluk kolísat, což člověk vnímá hůř než stabilní hladinu hluku.

Ventilátory GeForce GTX Titan

Bez zátěže běžel ventilátor na nízkých 1140 otáčkách (30 % výkonu) a nezaregistroval jsem žádné parazitní zvuky. V zátěži se žhavější z karet dostala až přes 2900 ot./min.

Druhé kartě stačilo k uchlazení necelých 2200 otáček.

Hlučnost SLI GeForce GTX Titan

V grafu s hlučností výsledek dvou karet ve SLI schází, důvod je prostý – hlučnost dvou karet běžících na různých otáčkách jsem neměřil. Teplejší karta má na 2900 ot./min hlučnost přibližně 51,3 dBA, když k ní připojíte druhou na 2200 otáčkách, bude výsledek ještě o něco vyšší.

Cena a shrnutí výkonu

Cena

Ceny jsou vybrané z některých velkých českých počítačovch e-shopů (Alfa Computer, Alza, Czech Computer), jde pokud možno o nejlevnější dostupné modely. Karty, které se už neprodávají, mají poslední ceny, za které byly k mání.

Protože cenu hledáme především kvůli porovnání poměru cena/výkon s nejvýhodnějšími kartami, které jsou ve stejnou dobu dostupné, nemusí odpovídat konkrétním testovaným modelům, ale může jít o levnější kartu na obdobných taktech.

Cena GeForce GTX Titan

Cena nemá u jednoprocesorové herní karty precedens, je hodně vzdálená tomu, co běžný smrtelních na hraní pořídí. A u dvou karet je to prostě dvakrát tolik.

Průměrný výkon

U každé hry počítáme celkový průměr ze všech měření, který následně započítáváme do celkového průměru. Každá hra je tedy v celkovém výsledku započtena stejnou vahou. Protože porovnáváme nejvýkonnější karty, z celkového průměru jsem tam, kde u her testujeme více nastavení detailů (nemyslím tím rozlišení), vypustil méně náročná nastavení, která používáme pro porovnávání slabších karet.

Jako základ, od kterého se počítá výkon dalších karet, slouží vždy nejvyšší skóre dosažené u všech testovaných karet.

Poměr cena/výkon

Jestliže to s poměrem cena/výkon nebylo u GTX Titan moc veselé, u SLI to platí dvojnásob. Víc asi není třeba dodávat.

SLI GeForce GTX Titan: závěrečné shrnutí

Když se podíváte na výsledky ve srovnání s dvojicí přetaktovaných Radeonů v CrossFire (navíc na starších ovladačích), není někde nárůst výkonu bůhví jak velký na to, že jde o řešení, za které dáte o třicet tisíc víc.

Jenže samotné GeForce GTX Titan jsou v tom často asi nevině, vypadá to, že jsou natolik výkonné, až je to ve výsledcích kontraproduktivní. V řadě her karty zjevně naráží na limit ze strany procesoru, který dvojici karet nestíhá zásobovat.

Další nevýhodou je microstuttering. Na podrobnější analýzu jsem zatím čas neměl, ale na pár výsledcích, které jsem zkusil, to nevypadá, že by se chování dvou karet jakkoliv lišilo od toho, nač jsme u multi-GPU řešení zvyklí (pochopitelně s výjimkou GTX 690 s frame rate meteringem). S vertikální synchronizací, se kterou se pochopitelně netestuje, to ale může být lepší.

V sestavě s dvojicí GTX Titan se ale nějakého viditelného trhání bát nemusíte – karty sypou snímky dost rychle na to, aby nebylo střídání rychlejších a pomalejších snímků pozorovatelné.

Stinnou stránkou je absence nějaké technologie, která by sekundární kartu ve 2D uspávala (Radeony HD 7000 umí sekundární kartu přepínat do ZeroCore). Kvůli tomu je spotřeba počítače bez zátěže o 15 W vyšší než s jednou kartou. Argumentovat 15 W navíc u řešení, kde jen dvojice karet stojí bezmála padesát tisíc, je ale přinejmenším úsměvné, v tomto případě jde spíše o princip.

I když na tom GTX Titan s poměrem výkon/watt není nikterak špatně, to, že v počítači běží dvě karty s TDP 250 W, je na teplotách komponent (i plechů skříně) znát. Znamená to, že pokud není počítač dostatečně chlazený (podobně jako v našem případě, kdy systémové ventilátory běží na nízkých otáčkách 700–800 ot./min), zaúřaduje regulace podle teploty a frekvence GPU u obou karet po chvíli zátěže klesne na základní takty 837 MHz. A když ani to nestačí, zvedají se i otáčky ventilátorů, takže je celé řešení o poznání hlučnější než jedna karta.

Jestli to závěrem chcete slyšet výslovně, dvě GeForce GTX Titan do SLI se nevyplatí. Jedním dechem dodávám, že pochybuju, že toho, kdo o něčem podobném vůbec uvažuje, něco takového zajímá.

SLI Nvidia GeForce GTX Titan

+ extrémní výkon

+ 6 GB paměti

± chladiče s radiálním ventilátorem

± vlastnosti i výkon výrazně závislý na teplotě GPU

± bohaté možnosti nastavení, říká si o vyladění na míru

− vyšší spotřeba bez zátěže

− výkon dvou karet může brzdit procesor

− SLI nemusí vždy dobře škálovat

− pro využití GPU Boost vyžaduje intenzivnější chlazení

− cena/výkon

− microstuttering (platí pro všechna řešení ze dvou karet)

Za poskytnutí sestavy HAL3000 s GeForce GTX Titan do testu děkujeme společnosti

100Mega Distribution s. r. o.

Za poskytnutí druhé grafické karty Gigabyte GeForce GTX Titan děkujeme společnosti eD' system Czech, a. s.

Graf ceny produktu Zotac GeForce GTX TITAN 6GB DDR5, ZT-70101-10P poskytuje server Heureka.cz