Na umělé inteligenci zdaleka nejvíc vydělává Nvidia, kterou prodeje datacentrových GPU vystřelily na tržby přes 20 miliard dolarů za kvartál. V menší míře se ale povedlo prosadit i AMD s akcelerátory Instinct. Firma teď na Computexu oznámila plány dalších generací těchto GPU následujících po nyní prodávaném MI300X. Firma by měla zrychlit vývoj v této oblasti a nové akcelerátory Instinct teď bude vydávat s jednoletou kadencí.

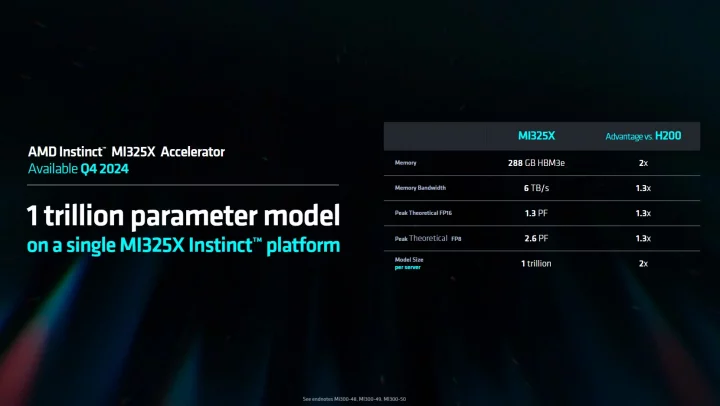

Instinct MI325X: GPU pro LLM s bilionem parametrů

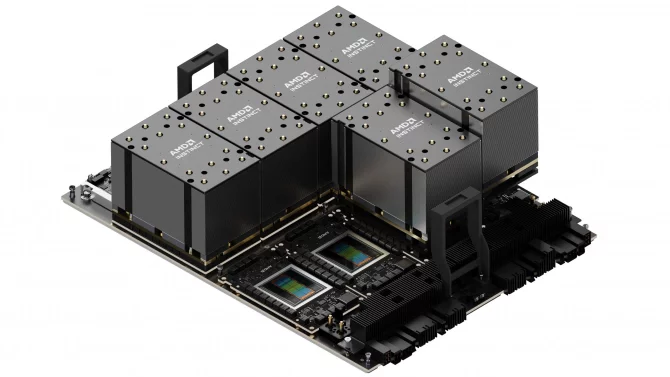

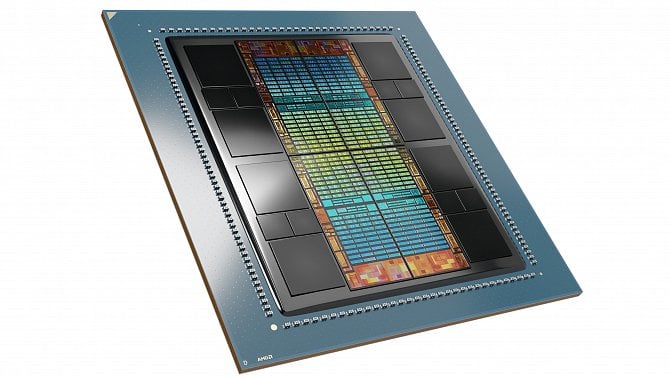

První z novinek, kterou AMD pro trh s AI akcelerátory a obecně výpočetní GPU chystá, je Instinct MI325X. Ten ještě není úplně novou generací, protože stále používá architekturu CDNA 3 a mělo by jít o adaptaci loňského modelu MI300X s větší a rychlejší pamětí HBM3E.

Zatímco MI300X má osazeno 192 GB paměti HBM3 s propustností 5,3 TB/s, model MI300X má místo toho osazených osm pouzder HBM3E, která dodává kapacitu 288 GB (jedno pouzdro má kapacitu 36 GB, používají 12 vrstev paměti DRAM o kapacitě 24 Gb).

Propustnost se o něco zvýšila, z 5,2 TB/s na 6 TB/s, čímž by zřejmě mohla zlepšit reálný výkon, ačkoliv specifikace výpočetní části (304 jednotek CU s 1216 maticovými jednotkami a 19 456 stream procesory, frekvence 2100 MHz) jsou, zdá se, stejné.

Zejména ale větší kapacita dovoluje provoz a trénování větších modelů neuronových sítí, což může být vůbec klíčové, protože právě ve zvětšování modelů spočívá pokrok v kvalitě výsledků a schopností různých AI modelů. TDP akcelerátoru by mělo zůstat na 750 W, i když potvrzené to zatím není, provedení je stále ve formátu OAM (OpenCompute Accelerator Module).

Tento akcelerátor díky kapacitě paměti dovoluje provoz neuronové sítě typu Large Language Model s bilionem parametrů na jednom serveru, pokud se do něj osadí osm akcelerátorů propojených dohromady, což dává 2,3 TB paměťového prostoru.

Tato GPU či akcelerátory (grafické výpočty už architektury CDNA nepodporují) budou vydány ve čtvrtém kvartálu letošního roku. Krátce nato by měla vyjít nová generace AI akcelerátoru od Nvidie (B200 Blackwell), ovšem MI325X před ním bude stále mít výhodu větší kapacity paměti na jeden akcelerátor, neboť Nvidia u B200 zatím nasadila kapacitu jen 192 GB. MI325X tedy může být relevantní i poté, přestože je refreshem předchozí generace.

Nvidia později pravděpodobně také vydá 288GB variantu, ale je možné, že toto je i její cílená segmentace a Jen-Hsun Huang se spoléhá, že zprvu zákazníky přiměje si kvůli tomu dejme tomu zhruba 2TB paměťovému prostoru koupit náročnější serverové systémy s více než osmi GPU, které přinesou větší tržby.

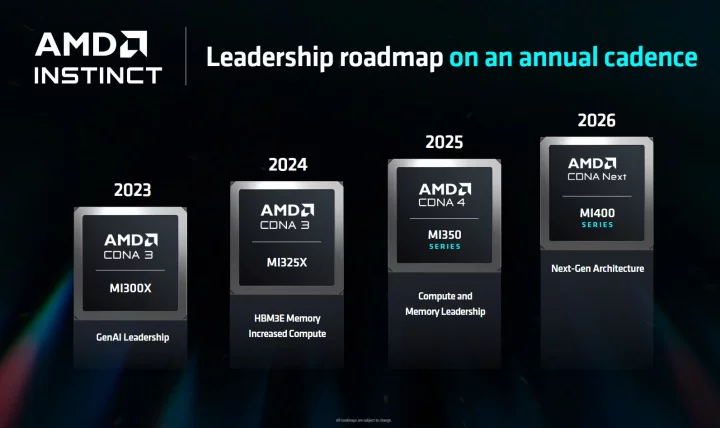

Roadmapa: Nové generace každý rok

Zatímco MI325X je produkt pro nynější rok, AMD ukázalo i následující roadmapu. Na té je důležité, že firma začne nové verze těchto AI akcelerátorů vydávat každoročně. To by mělo zrychlit vývoj a zlepšit její konkurenceschopnost (dlužno říct, že něco podobného chce dělat i Nvidia).

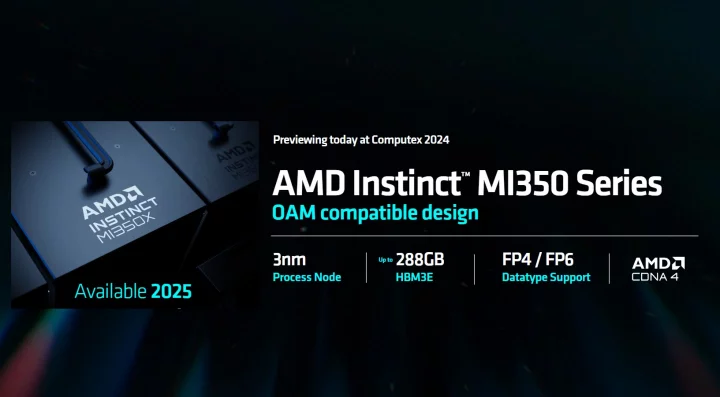

Instinct MI350X už má novou architekturu a 3nm proces

Na další rok má AMD naplánovanou generaci Instinct MI350X, což na první pohled zní jako další refresh MI300X/MI325X, ale zdání asi klame, protože zatímco ty mají obě architekturu CDNA 3, v Instinctu MI350X už je použitá nová architektura CDNA 4. Je však možné, že v ní budou relativně menší změny proti CDNA 3, když AMD tyto akcelerátory pořád označuje jako generaci MI300X.

MI350X přinese přechod na 3nm výrobní proces, což dovolí lepší výkon a energetickou efektivitu, jde o upgrade výrobní technologie o jednu „plnotučnou“ generaci (větší než z 5nm na 4nm). Tedy alespoň pokud AMD použije proces TSMC, což se zdá pravděpodobné.

Parametry pro tyto akcelerátory ještě zveřejněné nejsou, takže nevíme, jak moc jim přibude na výpočetních jednotkách. AMD uvádí, že bude mít „vedení v paměti a výkonu“, nicméně top konfigurace paměti má být opět 288 GB paměti HBM3E na jeden akcelerátor, pravděpodobně ale s vyšší rychlostí a propustností, protože u MI325X běží HBM3E na dost konzervativním taktu. Pokud se ale objeví 48GB pouzdra HBM3E (používající 12 vrstev 32Gb čipů DRAM), pak by mohla být v rámci nějakého refreshe poté paměťová kapacita zvýšená na 384 GB.

Z architektonických novinek bylo sděleno, že CDNA 4 přinese schopnost práce s datovými typy FP4 a FP6, tedy floating-point formátem s hodně minimální přesností. Toto by dovolilo dostat do určitého paměťového prostoru AI model s více parametry a také by GPU mohlo být schopné minimálně výpočty s přesností FP4 provádět s vyšším výkonem než FP8 nebo INT8.

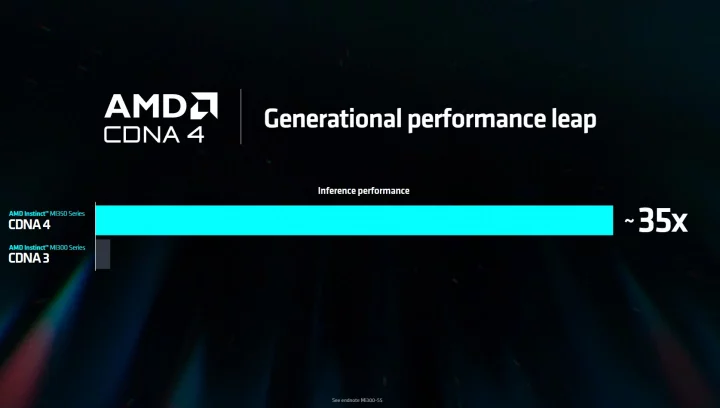

Výkon akcelerátorů generace MI350X má být podle AMD až 35× při inferenci, což bude asi při využití oné nižší přesnosti FP4, a jde údajně o srovnání dvou serverů s osmi GPU MI300X a MI350X, s modelem o 1,8 bilionu parametrů. Dle toho by velký výkonnostní zisk asi mohl být výsledkem toho, že model na MI350X poběží s nižší přesností, a nebude tak narážet na nedostatečnou paměť, snižující u MI300X výkon.

CDNA 5: „Next-gen“ architektura

Vetší architektonická změna by měla přijít poté, dle roadmapy v roce 2026. Tato generace by mohla nést pojmenování CDNA 5, ale oficiálně to ještě není potvrzené a asi může být zvoleno i nějaké jiné honosné označení, zatím jde prostě o CDNA Next. Má jít o „architekturu nové generace“ a už pro ni bude použito produktové jméno Instinct MI400X.

Více podrobností ale zatím AMD neříká. Tyto akcelerátory by se měly časově zhruba krýt s next-gen architekturou Nvidie, která se jmenuje Rubin.

Generace MI350X bude podle AMD už reálně dostupná před koncem roku 2025 (tedy nejen papírově uvedená), byť jde asi o předběžný termín s vyhrazenou možností změn, jak už je to obvyklé.

Naproti tomu u MI400X není ještě termín úplně potvrzený. V roadmapě je sice tato generace vyznačená do roku 2026, ale asi to nevylučuje, že v onom roce nastane jen papírové uvedení, zatímco reálná dostupnost sklouzne třeba do první poloviny roku 2027.

Zdroje: AnandTech, AMD, ServeTheHome