GT200: Grafická karta nejen pro grafiku: CUDA, kódování videa

GT200 či GeForce GTX série 200 je první grafickou kartou, která už při svém uvedení není prezentována pouze jako akcelerátor 3D her, či maximálně přehrávání videa. Už od doby unifikovaných prováděcích jednotek v grafickém jádře (stream procesory či shader procesory, dříve oddělené a specializované pixel a vertex shader jednotky) zkoumají výrobce možnosti využití vysoké míry paralelismu a síly grafických jader pro výpočty, jež dosud náležely výhradně procesoru.

Než se tedy propracujeme k obdivu parametrů kartu z pohledu hráče moderních 3D her, řekněme si něco o novější a možná i zajímavější stránce GT200. Všechno začalo už v době GeForce 8800 GTX (G80), prvního grafického čipu společnosti Nvidia s unifikovanými shader jednotkami. Pro tento čip vyvinula Nvidia jazyk zvaný CUDA. To není v podstatě nic jiného než rozhraní umožňující používat programování ve stylu jazyka C, jenže nikoli pro procesor (CPU), ale grafické jádro (GPU).

AMD (či dříve ATI) se vydala jinou cestou. Vytvořila pro svá GPU jazyk nižší úrovně (podobný assembleru) a tím větší volnost pro vývojáře. Nadstavba byla na nich. To bylo přímém kontrastu s kompletním servisem, ale zase jasně danými hranicemi, které poskytuje CUDA. AMD dlouho drželo prapor díky tomu, že oblíbený klient Folding@home existoval pouze ve verzi pro procesory či právě Radeony.

To se nyní mění a Nvidia už má pro svá GPU od této chvíle klienta také. Na samotnou charitativní činnost by dostatek nehráčů Nvidia nenalákala, a tak vytahuje ještě další těžký kalibr. Přes GPU akcelerovaný převod videa. Jestli si vzpomínáte, tak to už tu také jednou byla. Společnost ATI někdy v době R520 (Radeon X1800) přišla s Avivo Transcoderem, který dokázal převést video do formátu WMV9 násobně rychleji než dostupné procesory. Jenže ATI, jako tomu už bylo v historii hodněkrát, svůj počin do komerční a vyladěné podoby nedotáhla. Oproti tomu už má Nvidia první beta verze skutečných aplikací třetích stran, jež GPU transcoding využijí.

Buldočí Nvidia pracuje však zcela jinak. S technologiemi klidně přijde později, zato je má většinou dotažené a podpořené kompletním řetězcem nutným pro uchycení se a přežití. A to zahrnuje nejen technologii vymyslet, ale zajistit pro ni také aplikace (nejlépe ty s přívlastkem "killer") a marketing. Vijay Pande ze Stanfordské univerzity ve své prezentaci udělal hrubý a velice zajímavý odhad: na světě je momentálně asi 70 milionů grafických karet GeForce schopných provádět CUDA. Řekněme, že průměrný výkon těchto grafik je asi 100 GFLOPS. Pak dosud leželo ladem (z pohledu Pandeho, patrona Folding@home) zhruba 7000 PFLOPS (peta-). Pro srovnání: nejrychlejší počítač světa, IBM BlueGene/L, ještě nedosáhl ani hranice 0,5 PFLOPS.

To ale pořád ještě nejsou všechny trumfy Nvidie. Ta vytvořila i plugin pro Adobe Photoshop, spolupracuje s výrobcem 3D galerie PicLens, 3D sociální sítí Nurien (asi něco jako Second Life, ale půjde tam o módu a pro muže pak možná o pokoukání na hlavní avatary ladných křivek) a po nedávné akvizici společnosti Ageia, bude na svých GPU akcelerovat fyzikální engine PhysX. Ten je momentálně především v Unreal 3 enginu (a ještě například v Ghost Recon: Advanced War Fighter), ale Nvidia jej silou svého programu TWIMTBP protlačí jistě do mnoha titulů.

CUDA a aplikace

O Nvidia CUDA jsem psal již něco málo v úvodní kapitole článku, a tak už všichni dobře víte, co to je. Kaliforňané chtějí dokázat, že CUDA nezůstane zajímavou pouze pro programátory a vědce, ale pronikne také mezi běžné uživatele. První demoaplikací byla beta verze převaděče BadaBOOM od společnosti Elemental Technologies. Jedná se zřejmě o placenou aplikaci (i ona beta verze omezená jen na GTX 280 má krátkou zkušební dobu) s vynikajícím rozhraním pro naprosté počítačové začátečníky. Vyberete zdroj videosouboru a poté zařízení, pro které jej chcete zkonvertovat.

Jaký příklad jsem použil dodaný 184MB MPEG-2 v rozlišení 720p a ten byl aplikací s využitím akcelerace přes GTX 280 do H.264 transformován rychlostí téměř 150 snímků za sekundu, tedy asi pětinásobkem rychlosti přehrávání v reálném čase. Aplikace bohužel nepodporuje jiné grafické karty či přímo procesor, takže pro ty, kterým zatím zobrazená akcelerace nic neříká, mám jediné: zkuste si najít podobně velký MPEG-2 v 720p a převést jej do H.264 do 40 sekund. Výsledné video je v rozlišení 640 × 360 px bez ohledu na to, pokud vyberete iPhone. Pro jiné zařízení se použijejiné rozlišení, ale BadaBOOM v náhledu hlásil vždy stejně velký výsledný soubor. To se ale týká asi jen beta verze programu.

Další aplikací byla beta verze Folding@home klienta pro GeForce. Ta mi bohužel jela opět jen na GeForce GTX 280, ale možná budete mít větší štěstí. Můžete si ji vyzkoušet po stažení z tohoto odkazu. Rychlost počítání zobrazuje screenshot níže, čtenáře, kteří mají s počítáním F@h na procesoru či Radeonech už zkušenosti, poprosím o zveřejnění svých zkušeností s rychlostí počítání, abychom mohli vše porovnat.

CUDA samozřejmě neznamená jen Folding či kódování videa do H.264. Některé další aplikace uvidíte na obrázku pod odstavcem, násobky znamenají akceleraci přes GPU GeForce GTX 280 oproti nízko taktovanému dvoujádrovému procesoru (CPU).

O CUDA se mnohem více dozvíte na stránce CUDA Zone. Tam si také můžete stáhnout potřebný ovladač pro GeForce 8/9, stáhnout toolkit pro tvorbu CUDA aplikací či celé kusy kódu jako příklady. Na stránce také v pěkném prohlížeči uvidíte desítky (možná už víc jak stovku) aplikací, v nichž CUDA našla využití.

GT200: co skrývá obří jádro?

Jádro GT200 má nejen 1,4 miliardy tranzistorů, ale také až téměř neuvěřitelné rozměry. 24 × 24 mm znamená 576 mm čtverečních. Do takových rozměrů se například jádro Radeonu HD 3870 vejde asi třikrát. V duchu tradice a jistoty Nvidia u svého highendu sází na odzkoušený 65nm výrobní proces. Následující obrázek vám ukáže, jaké části si uzurpují největší plochu jádra.

Když klepnete na obrázek, zobrazíte si jádro v rozlišení 750 × 750 px, obrázek v rozlišení více jak 2400 × 2400 px (2,1 MB JPEG) si můžete stáhnout zde

Nvidia vnímá svou GT200 opravdu jako čip pro dva různé účely. Takto vypadá schéma z pohledu GPGPU (General Purpose GPU, tedy aplikace jako CUDA apod.), ROP (rasterizace) jednotky jsou rpo tento účel samozřejmě něčím zbytečným :

A takto jako grafická pipeline, tedy z pohledu 3D API typu DirectX:

Každý z deseti výpočetních clusterů (TPC, thread processing cluster) má 24 prováděcích jednotek, celkem tedy 240 stream procesorů.

Pokud si základní parametry nových GeForce shrnete do stručné tabulky, pochopíte, proč Nvidia považuje GeForce GTX 280 za ještě větší skok než byla GeForce 8800 GTX. To, že tomu tak není i v grafech herního výkonu mají na svědomí už jen vcelku doladěná dvoučipová řešení typu GeForce 9800 GX2 či Radeon HD 3870 X2.

Následující tabulka ukazuje ty samé parametry, jen v kontextu většího množství grafických karet (klepnutím na náhled ji zobrazíte v čitelné podobě):

Fotografie GTX 280 a 260, rozměry, požadavky na zdroj, GPU-Z

GeForce GTX 280

GeForce GTX 280 měří stejně jako třeba GeForce 8800 GTX/Ultra či 9800 GTX celých 27 cm. To je horní hranice pro kartu do běžných middle tower skříní. Chladič je tvarem podobný tomu, jaký znáte z GeForce 9800 GTX, není však plastový, ale z většiny kovový. Tím se zase podobá tomu, který znáte z GeForce 9800 GX2.

GeForce GTX 280 vyžaduje jeden 6-pin PCI Express a jeden 8-pin PCI Express 2.0 napájecí konektor. Nvidia doporučuje alespoň 550W zdroj se zatižitelností 40 A na 12V větvích.

Zajímavostí je doporučený procesor: Core 2 Duo E6300, případně Core 2 Duo E8500 pro SLI konfiguraci. Když Nvidia něčemu věří, hodlá to dokázat na všech frontách.

Chladič GeForce GTX 200 je podle Nvidie navržen tak, že GPU udrží v rozumně větrané skříni vždy pod 80 °C (prahová hodnota pro GT200 je nastavena na 105 °C). Větrák je plně regulovatelný (PWM), prozatím jej můžete regulovat minimálně v Nvidia Control Panelu u desek s nForce.

Teplotu a takty karty můžete slevovat v Nvidia Monitoring Tool, ATITool, GPU-Z a už i v RivaTuneru 2.09.

GeForce GTX 260

GeForce GTX 260 je prakticky stejná jako GTX 280, ale vyžaduje jen dva 6-pin PCI Express napájecí konektor a 8-pin PCI Express 2.0 tedy nepotřebujete. Nvidia pro GTX 260 doporučuje 500W zdroj se zatižitelností 36 A na 12V větvích.

GPU-Z a hlavní inovace v kostce

Významné inovace v architektuře

(většina ve srovnání s předchozím highend čipem Nvidie: G80)

- prudce vylepšená správa napájení, GeForce GTX 200 má nyní několik režimů:

- - idle/2D - spotřeba kolem 25 W

- - přehrávání HD videa Blu-ray - kolem 35 W

- - plná 3D zátěž - nejhorší případ (TDP): 236 W

- - režim HybridPower - 0 W (přepnuto na integrovanou grafiku)

- škálovatelná procesorová architektura (SPA) nové generace: několik TPC (clusterů), ke kterým se přistupuje buď jako k texturovacím

- navýšení texturovacích jednotek, namísto 32 (G80) jich v GT200 najdete 80 ( ale stejně jako u G92 pouze bilineárních, nikoli trilineárních jako u G80, poměr je tedy spíše 64:80)

- 32 ROP (blend) jednotek. G80 měla pouze 12

- dvojnásobná přesnost výpočtů v plovoucí desetinné čárce (FP64, k tomuto kroku se tedy Nvidia odhodlala až po ATI)

- video procesor 2 (VP2): konečně plná akcelerace Full HD H.264/VC-1 apod. na highendovém GPU

- dvojnásobná velikost souboru registru: především delší shader kódy jsou pak prováděny daleko rychleji a přitom si tento upgrade vyžádá jen velmi malou daň na tranzistorech a prostoru jádra (v 3DMark Vantage jen samotné dvojnásobné registry znamenají zhruba 10% nárůst výkonu)

- SFU, tedy takový ten už dobře známý přívěšek každého stream procesoru (special function unit) umožňující provádět ještě navíc další MUL operace (dual issue) je opět přítomen, ale celé toto spojení je optimalizováno k dosažení téměř 95 % efektivity - z dual issue pochází nemalá část výkonu

- vylepšené ROP i texturovací jednotky: zase toho umí více současně a v případě texturovacích jednotek je tu vyšší efektivita oproti G92 (v praxi údajně asi o 22 %), vyšší poměr shadery:ROP (moderní, ale AMD/ATI na tento vysoký poměr dosud doplácela, GT200 ale zůstává v oblasti TEX a ROP dostatečně robustní)

- 1 GB lokální grafická paměť (framebuffer) - to ocení především hry s obrovskými texturami ve spojení s velmi vysokým rozlišením a anti-aliasingem, Nvidia dává jako příklad hru S.T.A.L.K.E.R. (deferred rendering + shader anti-aliasing)

- výkon geometry shaderu je oproti GeForce 8800 GTX asi 3× vyšší a je tedy podle testu RightMark 3D 2.0 (test Hyperlight, nastavení Heavy) lepší než u dvoučipového Radeonu HD 3870 X2

- zvýšený výkon operace stream out s GS přímo souvisí a Nvidia i svým demem Medusa ukazuje, že věří v její častější využití

- 512-bitová paměťová sběrnice s osmi (64-bit) frame buffer jednotkami

- plná podpora 10bitových barev (už předchozí GPU Nvidia interně počítaly s 10-bit barvami, ale na výstupu bylo jen 8 bitů pro barevnou složku)

- další vylepšení: křížový řadič pamětí už netrpí zpomalováním při zpracování určitých primitiv; post-transform cache pro rychlejší komunikaci ve fázi mezi geometrií a vertexy; výkonnější Z-culling; lepší plánovač instrukcí atd.

Testovací sestava, použité testy

K postavení z většiny nové testovací sestavy jsem byl nucen sáhnout jednoduše pro to, abych i nejnovější grafické karty nijak nelimitoval. Ke slovu se tedy dostala základní deska s PCI Express 2.0 a dostatkem linek pro Multi-GPU zapojení, procesor jsem pro jistotu popohnal na 3,5 GHz, paměť rozšířil na 4 GB (32bitový operační systém Windows Vista, který používám především kvůli kompatibilitě, využije něco přes 3 GB, ale to bohatě na všechny současné hry stačí) a především svůj čas začal šetřit nasazením rychlého pevného disku. Použitý zdroj má celkem čtyři PCI Express 2.0 napájecí konektory (6 + 2-pin), skříň pak patří mezi ty nejtypičtější a naměřené teploty či zaznamenané problémy s rozměry by tak měly být cennou informací pro co nejvíce čtenářů.

| Monitor | HP LP3065 (30", S-IPS) |

| Procesor | Intel Core 2 Duo E6750 @ 3,5 GHz (1,33 V) |

| Základní deska | XFX nForce 790i Ultra SLI (FSB: 1,3 V, Unlinked) |

| Paměť | Kingston 2× 2GB DDR3-1600, 8-8-8-24, 2T (1,9 V) |

| Pevný disk | Western Digital VelociRaptor, 300 GB (10 000 ot./min) |

| Zdroj | Corsair CMPSU-750TX (12V: 60 A, 750 W) |

| Chladič CPU | Coolink Silentator + Noctua NF-P12 (1200 ot./min) |

| Skříň | Cooler Master Centurion 534 |

| Optická mechanika | Toshiba SD-H802A (HD DVD, DVD-ROM) |

| Systémové větráky | Noctua NF-S12-1200 (900 ot./min) |

| Cooler Master 12cm (900 ot./min) | |

| Operační systém | Windows Vista Ultimate SP1 |

| Ovladače Nvidia | Nvidia ForceWare 177.34 pro GeForce GTX |

| Nvidia ForceWare 175.16 pro GeForce 8/9 | |

| Ovladače ATI/AMD | ATI Catalyst 8.6 beta |

S novou sestavou přichází také nové ovladače a především změna výběru her. S bolestí v srdci jsem se rozloučil s tituly jako Splinter Cell: Chaos Theory, Gothic 3, Quake 4, Heroes of Might and Magic V či Half-Life 2: Lost Coast, vyškrtal DirectX 9 varianty u her, kde již existuje DirectX 10 verze, a celkově modernizoval. Nakonec zůstaly jen tři hry nevydané v roce 2007/2008, přičemž jak Oblivion, tak F.E.A.R. či Serious Sam 2 stále dokáží dobře reflektovat především výkon grafické karty. Zcela nově jsem zařadil hry Age of Conan, Assassin's Creed, Devil May Cry 4, Half-Life 2: Episode Two, Hellgate: London, Race Driver: GRID, The Witcher (Zaklínač) či u nás velice rozšířené závody Trackmania Nations Forever. Výsledkem snad budou testy, jejichž výsledky budou platit co nejdelší dobu.

| API | Vydáno | ||

| Teoretické testy | 3DMark Vantage 1.0.1 | DX10 | 2008/04 |

| 3DMark06 1.1.0 | DX9 | 2006/01 | |

| Hry | Age of Conan: Hyborian Adventures (2008.0520) | DX9 | 2008/05 |

| Assassin's Creed (1.01 pro ATI, 1.02 pro Nvidia) | DX10 | 2008/04 | |

| Bioshock (demo, 1.0) | DX10 | 2007/08 | |

| Call of Duty 4: Modern Warfare (1.6) | DX9 | 2007/11 | |

| Call of Juarez (DX10 official benchmark, 1.3.0.1) | DX10 | 2007/05 | |

| Company of Heroes: Opposing Fronts (2.301) | DX10 | 2007/09 | |

| Crysis (1.21) | DX10 | 2007/11 | |

| Devil May Cry 4 (DX10 benchmark) | DX10 | 2008/06 | |

| Enemy Territory: Quake Wars (demo, 2.0) | OpenGL | 2007/09 | |

| F.E.A.R. (1.08) | DX9 | 2005/10 | |

| Half-Life 2: Episode 2 | DX9 | 2007/10 | |

| Hellgate: London (1.2) | DX10 | 2007/11 | |

| Lost Planet: Extreme Condition (1.004) | DX10 | 2007/06 | |

| Medal of Honor: Airborne | DX9 | 2007/09 | |

| Race Driver: GRID (demo) | DX9 | 2008/06 | |

| Serious Sam 2 | DX9 | 2005/10 | |

| S.T.A.L.K.E.R. (Shadow of Chernobyl) | DX9 | 2007/03 | |

| The Elder Scrolls IV: Oblivion | DX9 | 2006/03 | |

| The Witcher (Zaklínač, 1.3) | DX9 | 2007/10 | |

| Trackmania Nations Forever | DX9 | 2008/04 | |

| Unreal Tournament 3 (demo) | DX9 | 2007/11 | |

| World in Conflict (1.008) | DX10 | 2007/09 |

Grafické karty testujeme na 30" LCD panelu HP LP3065:

Za poskytnutí testovacích pamětí DDR3 děkuji společnosti Kingston:

Za poskytnutí největší části testovacích her pro testování děkuji společnosti CD Projekt.

Nastavení ovladačů:

- Nvidia ForceWare – Vsync: off, Quality: high, transparency AA: off, max. pre-rendered frames: 3

- ATI Catalyst – Vsync: off, Quality: high, adaptive AA: off

Konkurenci pro GeForce GTX 280 zajistily tyto karty:

Nvidia GeForce 9800 GX2, eVGA GeForce 8800 GTX, Sapphire Radeon HD 3870 Toxic (mírně vyšší než ref. karty), Nvidia GeForce 8800 GT a Asus Radeon HD 3870 X2 TOP (opět mírně vyšší než ref. takty)

3DMark06, 3DMark Vantage

3DMark Vantage

Zájemci o v 3DMarku Vantage použité technologie jejich popis najdou v tomto whitepaperu (PDF). V grafech najdete p

| 3DMark Vantage | Performance | 1280 × 1024 | ||||

| Radeon HD 3870 |

GeForce 8800 GT |

GeForce 8800 GTX |

Radeon HD 3870 X2 |

GeForce 9800 GX2 |

GeForce GTX 280 |

|

| GPU score | 4320 | 4333 | 5073 | 7032 | 9094 | 9914 |

| Texture fill | 356 | 470,8 | 513,7 | 734,5 | 1065,47 | 672 |

| Color fill | 3,11 | 2,84 | 4,28 | 5,3 | 6,09 | 6,67 |

| POM | 8 | 9,5 | 10,45 | 16,1 | 21,2 | 30,64 |

| GPU cloth | 8,79 | 19,76 | 21,91 | 9,3 | 20,02 | 28,12 |

| GPU particles | 16,13 | 24,2 | 26,75 | 16,8 | 25,89 | 36,84 |

| Perlin noise | 22,14 | 19,1 | 22,62 | 45,2 | 43,43 | 55,31 |

3DMark06

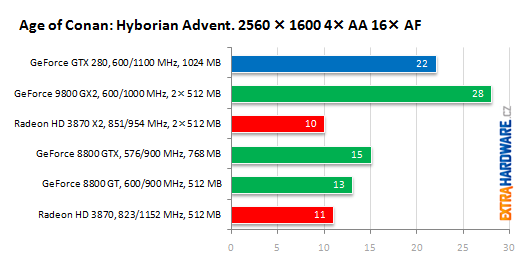

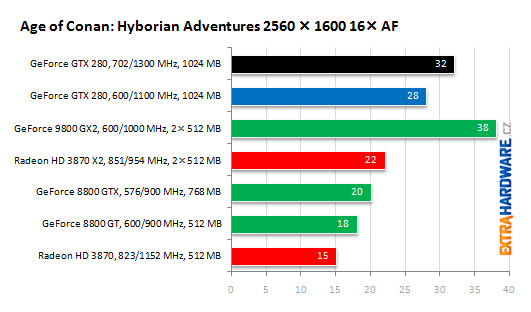

Age of Conan: Hyborian Adventures (DX9)

V Conanovi jsem shledal jako (z počátku hry) nejnáročnější kombinaci vody a viditelnosti velké části lesa, benchmarkuji vždy stejnou scénu pomocí FRAPSu. Fps odečítám přímo z obrazovky, protože měření pomocí FRAPSu (implicitně F11) se hrou nějak koliduje a výkon je u všech karet drasticky nižší (chvíli i 0 fps).

Assassin's Creed (DX10)

U Assassin's Creeda mám nainstalovány dvě různé verze, jednu bez patche (1.01, retail) a druhou s patchem 1.02. Karty ATi Radeon s podporou DirectX 10.1 podávají v neošetřené verzi podstatně vyšší výkon, nějakých vad v obraze jsem si (alespoň v testované části) nevšiml.

| Assassin's Creed na HD 3870 X2 | ||

| 1680 × 1050, AA 1/3 | 1.02 | 1.01 |

| static | 40,1 | 45,6 |

| run | 54,4 | 63,0 |

| min. fps | 23 | 36 |

| 1680 × 1050, AA 3/3 | 1.02 | 1.01 |

| static | 31,6 | 45,9 |

| run | 41,4 | 58,6 |

| min. fps | 17 | 30 |

Nejprve jsem FRAPSem měřil proběhnutí od stromu dole u studny až po hrad na kopci, při seběvětší snaze o co nejpodobnější opakování je v měření dávka nepřesnosti.

Měření jediné scény (na místě) po přesně daný časový úsek je přesnější, ale zase poněkud méně zachycující různé prvky enginu.

Bioshock (DX10)

Bioshock staví na Unreal 3 enginu a přidává DirectX 10 povrchy. Testuji s nejvyššími možnými detaily, vypnuté nechávám globální osvětlení (global lighting). Hra nemá zabudovaný benchmark, a tak testuji pomocí FRAPS. Vybral jsem velmi náročnou část z počátku hry – od vašeho vynoření se na hladině, kolem ohně až do majáku.

Bioshock mi bohužel ve své DirectX10 verzi s Catalyst 8.6 beta a CrossFireX neškáloval (nepomohlo ani přejmenování soubory ani Cat. AI na Advanced), později jej zkusím přeměřit s jinými ovladači.

U karet ATI se podle mě i přes vynucení v ovladačích (což by pro Unreal 3 engine již mělo být možné) zapnulo jen anizotropní filtrování a 4× anti-aliasing nikoli.

Call of Duty 4 (DX9)

Call of Duty 4 je pro vás podle naší ankety stejně atraktivní volbou jako Crysis nebo Zaklínač, a tak vás určitě výkon karet v této hře bude zajímat. Testoval jsem s téměř všemi detaily na maximu, velikost textur jsem změnil na Extra, anti-aliasing i anizotropní filtrování jsem zapínal přes nabídku hry.

Call of Juarez (DX10)

Call of Juarez je zastoupen DX10 Official Benchmarkem, není to tedy testování přímo v samotné hře. V několikaminutovém náročném průletu je demonstračně nacpáno hned několik náročných DirectX 9/10 technik. Benchmark je předmětem sporu Nvidie a Techlandu a používá jej s oblibou ATI/AMD při prezentacích 3D výkonu.

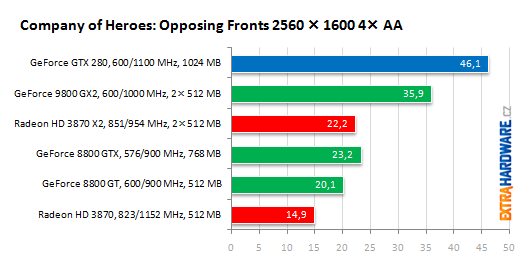

Company of Heroes: Opposing Fronts (DX10)

V Company of Heroes používám zabudovaný benchmark. Testovaná verze je 2.301, hru je potřeba spustit s parametrem -novsync. Všechny detaily mám nastaveny na možná maxima, oproti screenshotům níže i fyziku.

Crysis (DX10)

Crysis je jedním z pádným argumentů pro nákup nové grafické karty, byť v DirectX 9 režimu. Testoval jsem s celkovou úrovní detailů „High“ a všechny DirectX 10 karty pak i s „Very high“, anti-aliasing jsem zapínal ve hře. Testuji pomocí GPUbenchmark.bat (průlet kolem ostrova), plnou verzí hry s nainstalovanou záplatou 1.1.

Devil May Cry 4 (DX10)

Benchmark Devil May Cry 4 se objevil jako blesk z čistého nebe, kromě pohledné grafiky vyniká skvělou optimalizaci. Hra ve vysokých detailech doslova létá i na průměrných kartách. To je dost v kontrastu s jiným enginem Capcomu (Lost Planet). Do grafu budu používat výsledky z druhé, graficky asi nejvydařenější (až na statickou flóru) a nejnáročnější scény.

Upozorňuji, že jsem k ovladači 175.16 pro Devil May Cry 4 měl správný SLI profil. CrossFireX kupodivu fungoval s DMC4 rovnou a hlavně škáloval velmi dobře.

| Devil May Cry 4 | 1680 × 1050 | 94,6 | 67,7 | 114,7 | 64,4 | |

| 8800 GT | 1680 × 1050 | 4× AA 16× AF | 73,8 | 51 | 89,8 | 52,8 |

| 2560 × 1600 | 45,9 | 34,5 | 52,3 | 33,2 | ||

| 2560 × 1600 | 4× AA 16× AF | 33,6 | 24,9 | 39,1 | 26,4 | |

| Devil May Cry 4 | 1680 × 1050 | 70,6 | 53,5 | 91,4 | 56,5 | |

| HD 3870 | 1680 × 1050 | 4× AA 16× AF | 61,6 | 41,4 | 76,5 | 50,9 |

| 2560 × 1600 | 40,6 | 32,6 | 47,5 | 33,9 | ||

| 2560 × 1600 | 4× AA 16× AF | 35 | 25,8 | 41,9 | 30,1 | |

| Devil May Cry 4 | 1680 × 1050 | 104 | 74 | 130,5 | 72 | |

| 9800 GX2 | 1680 × 1050 | 4× AA 16× AF | 78,1 | 55,9 | 100 | 57 |

| 2560 × 1600 | 52,8 | 39,1 | 58,4 | 39,8 | ||

| 2560 × 1600 | 4× AA 16× AF | 38,2 | 28,2 | 46,1 | 29,8 | |

| Devil May Cry 4 | 1680 × 1050 | 125,4 | 98,8 | 161,1 | 95,6 | |

| HD 3870 X2 | 1680 × 1050 | 4× AA 16× AF | 110,2 | 79,1 | 140,6 | 88,5 |

| 2560 × 1600 | 72,9 | 58,9 | 86,3 | 58,7 | ||

| 2560 × 1600 | 4× AA 16× AF | 62,7 | 47,8 | 73,3 | 52,3 | |

| Devil May Cry 4 | 1680 × 1050 | 168,2 | 117,5 | 218,2 | 114,5 | |

| GTX 280 | 1680 × 1050 | 4× AA 16× AF | 118,5 | 82,5 | 151,9 | 80,3 |

| 2560 × 1600 | 82,6 | 59,9 | 99,6 | 58,5 | ||

| 2560 × 1600 | 4× AA 16× AF | 69,9 | 49,2 | 79,8 | 49,6 | |

| Devil May Cry 4 | 1680 × 1050 | 87,4 | 61,5 | 104,9 | 62 | |

| 8800 GTX | 1680 × 1050 | 4× AA 16× AF | 69,5 | 52,5 | 85,4 | 52 |

| 2560 × 1600 | 47,2 | 35,1 | 58,2 | 35,3 | ||

| 2560 × 1600 | 4× AA 16× AF | 39,6 | 27,8 | 46,8 | 29,9 |

Enemy Territory: Quake Wars (OpenGL)

Nové Enemy Territory představuje jedinou současnou moderní OpenGL hru pod Windows a zároveň jediný OpenGL test v testovací sadě. Quake Wars používají značně upravený Doom 3 engine, obohacený především o technologii MegaTexture (více o technologii v článku na Beyond3D). Pro testy používám maximální detaily, přes konzoli vypínám limit 30 i 60 fps, AA i AF zapínám ve hře, patch 1.1 by měl řešit problémy se soft particles. Ty jsem měl u všech karet kromě Radeonu X1950 Pro zapnuty (u této karty to hra nepovolí), ale zkusil jsem karty přeměřit i s vypnutými soft particles a tato položka neměla vliv na výkon ani u GeForce 8600 GTS.

Pro účely testování jsem si nahrál vlastní timedemo (recordtimenetdemo), které měří výkon v rozsáhlé lokaci se stromy (Valley). Timedemo (pro verzi 2.0) ke stažení: zde.

F.E.A.R. (DX9)

Engine hry F.E.A.R. se díky datadisku stal znovu aktuálním a ukazuje se, že se jedná stále o dobrý test grafik: procesor hraje jen velmi malou roli. Všechny detaily mám nastaveny na maximální hodnoty a všechny obraz vylepšující funkce včetně měkkých stínů zapnuty. Testuji zabudovaným benchmarkem.

Half-Life 2: Episode 2 (DX9)

Half-Life 2: Episode Two je při výběru správné lokace přece jen náročnější než starší tech. demo Lost Coast. Ve vyšším rozlišení mi vlastní timedemo dokonce rozškáluje i ty nejsilnější karty, což mě příjemně překvapilo.

Hellgate: London (DX10)

Testování v Hellgate: London je kvůli náhodnosti generování map velmi těžké, musíte udělat více průchodů a průměrovat. DirectX 10 verze je násobně náročnější než ta využívající jen DirectX 9.

Teprve později jsem zjistil, že hra u karet ATI Radeon neumožňuje nastavit anti-aliasing více než na hodnotu medium, dodatečně takto naměřím tedy i GeForce.

Zapnutí anti-aliasingu na very high (i medium pro ATI) ve 2560 × 1600 px znamená zatuhnutí aplikace na všech kartách kromě těch s frambufferem větším než 512 MB.

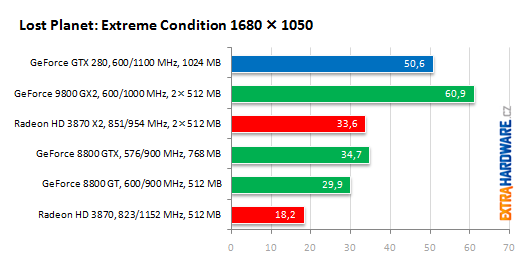

Lost Planet: Extreme Condition (DX10)

Lost Planet byla vůbec první PC hrou, která přímo vyšla s podporou DirectX 10. Pro měření výkonu grafik je důležité nepoužívat demo se zastaralým kódem, naopak updaty plné hry až na 1.004 přinesly několik optimalizací. Všechny detaily nastavuji na high, fur quality a filter quality pak na „DX10“. Nově na hodnotu „DX10“ nastavuji také shadow quality Počet souběžných (concurrent) operací byl pro testovaní s Core 2 Duo nastaven na 2, Multi-GPU zapínám jen v případě SLI či CrossFireX zapojení (příp. karty). Používám vestavěný benchmark.

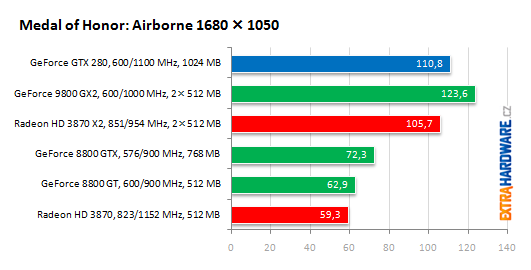

Medal of Honor: Airborne (DX9)

Medal of Honor: Airborne je jednou z mnoha nových her používajících Unreal 3 engine. Tím pádem přináší solidní kombinaci vzhledu a plynulosti na dostupném hardwaru. Testuji opět s vysokými detaily (a druhým nejvyšším nastavením kvality textur). Hra nemá zabudovaný benchmark, používám tedy FRAPS a vždy stejnou scénu letu letadla a seskoku z padáku.

U karet ATI Radeon se opět nezapínal vynucený anti-aliasing, jejich výsledky z příslušných grafů tedy zřejmě odstraním.

Race Driver: GRID (DX9)

Měřím FRAPSem od předstartovní animace až po první zatáčku, kde už se může něco náhodného semlet. Pro měření jsem vybral trať v San Franciscu. Používám profil vysokých detailů (Ultra), jen anti-aliasing (MSAA) a rozlišení si upravuji podle potřeby.

Do třetice všeho dobrého: ještě zkusím porovnat screenshoty, ale mám pocit, že i v tomto případě se na Radeonech nezapnul dokonce ani hrou nastavený 4× MSAA.

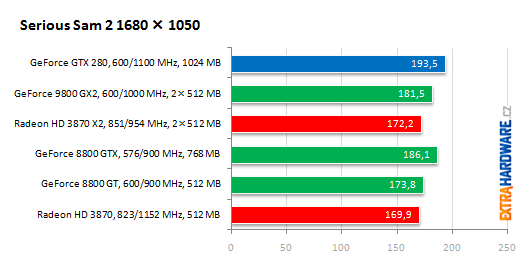

Serious Sam 2 (DX9)

Starší DirectX 9 hra je s maximálními detaily, HDR a ve vyšším rozlišením stále dobrým testem grafických karet. Croteam enginy umí, i v Serious Sam 2 použil několik zajímavých technologií (třeba jako jeden z prvních využil kompresi ATI 3Dc). Pomocí zabudovaného benchmarku, který můžete ovládat skriptem, měřím výkon v demu Branchester.

Testovací skripty ke stažení: zde.

S.T.A.L.K.E.R.: Shadow of Chernobyl (DX9)

Engine Stakleru, X-Ray engine, je zajímavý mimojiné tím, že používá deferred shading umožňující velké množství dynamickýh zdrojů světla. Ve hře se setkáte s normálovým a paralaxním mapováním, měkkými stíny, FP HDR, dynamickými efekty počasí a mnoha postprocessingovými efekty. Ukrajinský tým už pracuje na pokračování na vylepšeném enginu (Clear Sky).

Na popud jednoho z čtenárů jsem nakonec změnil metodiku testování ve hře S.T.A.L.K.E.R.: Shadow of Chernobyl. Byl jsem v diskuzi upozorněn na příliš vysoká fps oproti reálnému hraní. Vytvořil jsem si tedy poměr spolehlivou metodu průchod začátku mapy s Agroprom Research Institute, kde projdu po cestě až k předskriptované sekveci zobrazující přestřelku stalkerů a armády v prostorách před institutem. Poměry sil zůstaly téměř zachovány, ale mám dobrý pocit z kvalitnější a časově náročnější metody měření.

Soubor s nastavením ke stažení: zde.

The Elder Scrolls IV: Oblivion (DX9)

Čtvrtý díl série Elder Scrolls patří i přes svůj věk stále mezi nejnáročnější hry vůbec. Zvlášť, když stejně jako já v testu, vyberete lokace s množstvím vlnící se trávy, pohupujících se stromů a přesto rozhledem do vzdálené krajiny. Testuji s maximálními detaily a HDR.

Soubor s nastavením (vše na maximum) a dvě uložené testovací pozice ke stažení: zde.

The Witcher (Zaklínač) (DX9)

Původně jsem chtěl grafické karty v Zaklínačovi testovat v nejnáročnější lokaci - Obchodní čtvrti Wyzimy - ale v ní jsou silné grafické karty bohužel limitovány jinou částí systému:

| The Witcher | obchodní čtvrť | GeForce GTX 280 |

| 1680 × 1050 | 16× AF | 38,3 |

| 1680 × 1050 | 4× AA 16× AF | 37,4 |

| 2560 × 1600 | 16× AF | 38,0 |

| 2560 × 1600 | 4× AA 16× AF | 37,0 |

Nakonec jsem si tedy našel jinou náročnou část, která ale vytěžuje pro změnu především grafickou kartu. Jedná se o háj druidů v lese na Blatech.

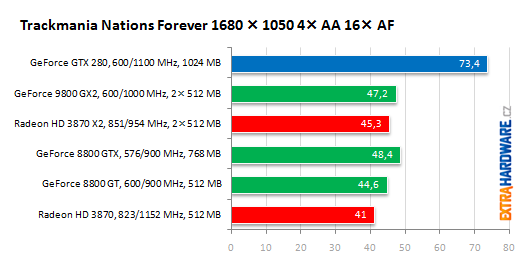

Trackmania Nations Forever (DX9)

Trackmaniu hraje nejen ve světě, ale i v ČR obrovský počet hráčů, hra má navíc zabudovanou možnost benchmarku. Škoda jen zatím nevysvětlitelného chování, kdy ve vyšším rozlišení (dokud nezapnete anti-aliasing) obdržíte vyšší výsledek. Jinak hra na plné detaily zatíží jakoukoli dnešní grafiku a není velkým přítelem Multi-GPU.

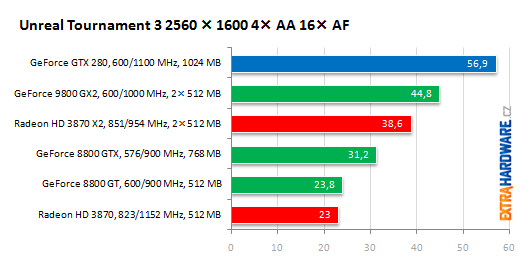

Unreal Tournament 3 (DX9)

Bude to nuda, ale napíšu to, co píší všude: Unreal Tournament 3 je příkladem skvěle optimalizovaného enginu, skvěle vypadá a přitom je velmi svižný i na běžném hardwaru. Před testováním musíte v UTEngine.ini vypnout vyhlazování snímkové frekvence (implicitně nastaveno na interval 22 až 62 fps) a to tak, že najdete bSmoothFrameRate=True a nastavíte na False (předtím odstraňte u souboru atribut Jen pro čtení). Pro grafické karty je lepší flyby, pro realističtější výsledky pak botmatch, testoval jsem pomocí flyby a vybral jsem pěkně vypadající mapu ShangriLa.

Nastavení hry ke stažení: zde.

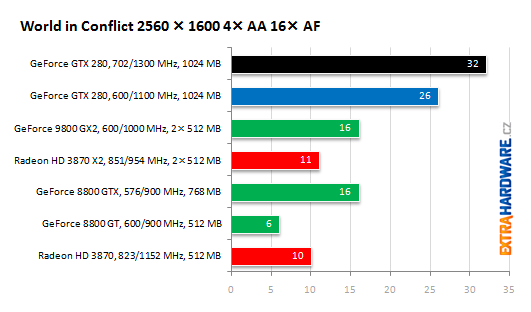

World in Conflict (DX10)

World in Conflict je asi nejlépe vypadající strategie, zástupce nové vlny DirectX 10 a dobrý benchmark procesoru. Tyto karty jsem testoval ve 1 680 × 1 050 px s upraveným profilem very high details (zapnul jsem i water reflects clouds, pouze anti-aliasing a anizotropní filtrování měním dle potřeby toho kterého grafu). Používám vestavěný benchmark. Při testování pod Windows XP jsem samozřejmě musel použít jen DirectX 9 režim (stíny z mraků na vodě si musíte pod DX9 odpustit).

Spotřeba, teplota, hlučnost, minimální fps

Spotřeba celé sestavy

Spotřebou sestavy jsem se zabýval opravdu dlouho. Nejdříve jsem myslel, že by mohl dobře posloužit ATITool, později 3DMark či Crysis. Ale ATITool vysokou spotřebu (na rozdíl od teplot) neudělá a jak v 3DMarku, tak v Crysis spotřeba dost kolísá. Nakonec jsem vybral graficky náročnou scénu z Bioshocku (oheň), ku které karty vykazují konstantní spotřebu. Ta by byla vyšší u Radeonu HD 3870 X2, a to v případě, že by fungovalo korektně spojení CrossFireX dvou RV670 na něm osazených. GeForce GTX 280 mi vychází překvapivě úspornější než divoký sample GeForce 9800 GX2. U něj TDP 197 W snad ani nevěřím. GT200 potvrzuje také velmi příznivou hodnotu spotřeby ve 2D režimu, aby to ale bylo oněch 25 W, měla by podle mě být ještě nižší. Možná výrobce nepočítal se zapnutým Aero a rozlišením desktopu 2560 × 1600 px.

Tak, jako jsem už dříve zjistil, jak moc závisí teplota na spotřebě čipu (hlučné chlazení Asusu je velmi účinné, možná odtud také ta nízká spotřeba Radeonu HD 3870 X2), nyní jsem si (nejen) v Bioshocku ověřil, že vyšší detaily a náročnější nastavení neznamenají automaticky vyšší spotřebu. Spíše naopak. Je třeba najít nějaký rovnovážný bod, kdy jsou sice detaily co nejvýše, ale tak, aby všechny části GPU stíhaly. Typicky, když zapnete 4× anti-aliasing, budete mít většinou nižší spotřebu než bez něj. To proto, že velká část GPU čeká na jednotky, jež se při anti-aliasingu stanou úzkým hrdlem (ROP, paměťová sběrnice, ...).

GeForce GTX 280 potvrzuje zvěsti o velmi nízké spotřeba v 2D/idle, optimalizace jako takt pamětí snížený na 100 MHz jsou chvályhodné.

Teplota

Hlučnost

Hlučnost jsem hodnotil opět jen subjektivně, na testované karty to bohatě stačilo. Nemáte-li mimořádně ztišený počítač, bude pro vás GeForce 8800 GT takřka neslyšná, za ticho ale platíte vysokými teplotami. Sapphire Radeon HD 3870 Toxic je velmi hlučný, Asus Radeon HD 3870 X2 takřka nesnesitelný. Velmi hlučný je i vzorek GeForce 9800 GX2 od Nvidie, to platí ale až při delší zátěži, kdy se karta zahřeje.

GeForce GTX 280 je ve svém zvukovém projevu velmi podobná GeForce 8800 GTX. Po startu se na chvíli rozhučí, ale velmi rychle utichne, pak se větrák točí zhruba 550-800 ot./min (30 či 40 %) a karta bude pro většinu z vás dostatečně tichá. V zátěži se větrák rozfouká více, hlučný sám o sobě není, ale tlačí docela dost vzduchu přes úzký prostor mezi žebry pasivu a docela malé otvory v mřížce ven ze skříně. Pokud kartu zatěžujete dlouhodobě, je už foukání dost silné, ale ani v tom si GTX 280 nijak s GeForce 8800 GTX od eVGA nezadala.

Minimální fps

U velké části her jsem zaznamenával rovněž minimální fps. Samy o sobě nemají velkou vypovídací hodnotu (propad může být ojedinělý), pokud však v celém sloupci budete nacházet polární hodnoty (tedy napříč hrami), už to něco znamená.

Teprve převod do relativních hodnot lépe odhaluje slabší a silnější grafiky. Nejnižší propady snímkové frekvence jsou silnou zbraní GeForce GTX 280.

Přetaktování a regulace větráku

Pro přetaktování jsem vyzkoušel dva nástroje: nejprve ten vestavěný přímo v Nvidia Control Panelu. Ten mi ale nechtěl povolit nastavit frekvenci jádra na 650 MHz. Stáhl jsem tedy nový RivaTuner 2.09, který již poslední GeForce podporuje a použil tento.

Zjistil jsem, že pokud deaktivujete volbu Linked (spojené taktování jádra a shader domain, stream procesorů), můžete sice taktovat stream procesory (Shader clock), ale změna frekvence jádra nemá žádný vliv. Jinými slovy, pro jádro můžete nanstavit třeba 800 MHz, ale nestane se to. Musíte jen v Linked režimu společně se stream procesory.

3DMark06 bylo možné i v 2560 × 1600 px a s 4× MSAA projet s taktem jádra/SP na 713/1538 MHz (Canyon Flight v tomto nastavení mimochodem běží přes 45 snímků za sekundu), 3DMark Vantage také, ale jen na nastavení Performance. Nastavení Extreme mě donutilo takt o pár MHz snížit na 705/1517 MHz.

U pamětí jsem už nejvyšší stabilní hodnotu nehledal s takovou přesností, při 1330 MHz se při testech objevila modrá obrazovka smrti, takže jsem se pokojil se 1300 MHz. 2,6 GHz efektivně je ale více, než bych kdysi při uvedení prvních 500MHz (1 GHz efektivně, 2,0 ns) GDDR3 modulů čekal.

Celkové přetaktování 705/1517/1300 MHz (jádro/SP/paměti, toto nastavení si generátor taktu přizpůsobí na nejbližší krok, přesněji tedy 702/1512/1296 MHz) bylo plně stabilní, až po delším testování jsem objevil drobné artefakty v DirectX 10 verzi Assassin's Creeda. To by zřejmě vyřešilo ještě pár MHz dolů na taktu jádra.

Jak už jsem zmínil, taktovat bylo možné i v nástroji společnosti Nvidia pracujícím na základních deskách s čipovou sadu Nvidia nForce. S tím samým nástrojem můžete GeForce GTX 280 zcela utišit, nebo naopak nechat na maximum chladit. Při 25 % otáček je už větrák velice tichý (implicitně jsem měl nastaveno 40 %) a současně to na uchlazení ve 2D režimu stačí. Myslím, že pro příznivce večerního sledování filmů se jedná o dobrou zprávu.

Výkon GeForce GTX 280 po přetaktování

Běh první městem:

Přesnější měření na jediném místě (studna u stromu):

Shrnující grafy

Jak na ExtraHardware počítáme grafy celkového výkonu: Pro každý dílčí test (tedy například Bioshock, 1680 × 1050 px) je nalezena nejrychlejší grafická karta a ta je označena jako maximum, tedy 100 %. Ostatní karty pak získají body v podobě relativního výkonu k tomuto dílčímu maximu. V dalším testu může být maximem zase jiná grafická karta, celkových 100 % by získala jen grafická karta nejrychlejší úplně ve všech testech. Tato metodika dává všem hrám stejnou váhu, bez ohledu na to, zda v ní karty běží typicky 30 fps nebo třeba 100 fps. Větší váhu mají jen hry Crysis a Assassin's Creed, ve kterých testuji vlastně dvakrát (u Crysis v high a very high, v Assassin's Creedu staticky a pak ještě během celým městem odspodu až po hrad).

Upozornění: kvůli nefunkčnímu anti-aliasingu u her Race Driver: GRID, Bioshock a Medal of Honor: Airborne v případě karet Radeon jsem tyto do shrnujících grafů počítal jen v nastaveních bez anti-aliasingu.

Spočítání poměrů výkon/cena mi trochu zkomplikovaly od výrobců mírně přetaktované Radeony. Ty se prodávají výrazně dráže než běžné verze (Toxic za 3460 Kč a X2 TOP za 7890 Kč) a následující grafy by to dost zkreslilo v neprospěch AMD. Kdybych jim ale zase počítal nejnižší nalezenou cenu podobného, ale nepřetaktovaného modelu (tedy standardního Radeonu HD 3870 DDR4 a Radeonu HD 3870 X2, momentálně asi 2830 Kč, resp. 7350 Kč), budu je zvýhodňovat. Nakonec jsem to tedy udělal tak, že jsem spočítal procentní nárůst frekvence, jež mají oproti referenčnímu modelu díky přetaktování (jádro i paměti, z toho průměr) a tyto zhruba 2 % k ceně netaktovaného modelu přičetl (a dostal ceny 2900, resp. 7680 Kč). Konzistentnost grafu s poměrem výkon/cena by tak měla zůstat téměř zachována.

Udělal jsem pro vás opět modelovou roční spotřebu elektřiny PC s danou grafikou. Graf počítá s 300 dny puštěným počítačem, na kterém se průměrně čtyři hodiny dělá něco něnáročného ve Windows (2D) a hodinu denně se hraje náročná 3D hra.

Verdikt

V diskuzích čtu od nemálo uživatelů slova zklamání. Podle mě ale nejsou tak úplně na místě. GeForce 280 GTX mě osobně rozhodně nezklamala. Předchozí velmi povedenou generaci překonává suma sumárum o nějakých 60 %, v rozlišení 30" LCD panelu (2560 × 1600 px) pak ještě více.

Situaci trochu zamotávají dvoučipové karty jako Radeon HD 3870 X2 a především GeForce 9800 GX2. Ty jsou i ve vysokém rozlišení často rychlejší, především pak v případě GeForce 9800 GX2 je Multi-GPU škálování výkonu celkem pravidelně nad 80 %. Ale jakmile dojde na opravdové HD hraní (velmi vysoké rozlišení a anti-aliasing), dochází těmto řešením disponujícím v AFR režimu v podstatě jen 512MB grafickou pamětí a 256bitovou paměťovou sběrnicí dech.

A bavíme-li se o highendu, o segmentu kde jsou peníze na drahé monitory, drahá PC a také drahé grafické karty, poměr cena/výkon je tedy až na druhém místě. V něm bude jistě lepší GeForce GTX 260, která nestojí 11 500 Kč, ale po větším rozšíření by se měla prodávat snad kolem 9 000 Kč a podávat přitom v širším spektru her jen zhruba o 10 % nižší výkon.

GeForce GTX 280 má proti dvoučipovým kartám další výhody v mnohem nižší hlučnosti, snadnější budoucí náhradě chladiče, snadnější a spolehlivější rozšiřitelnosti výkonu (SLI) a oproti GeForce 9800 GX2 s ní navíc spálíte daleko míň elektřiny. A ještě dvě věci tato Multi-GPU řešení penalizují: nikdy si nemůžete být jisti zda některý titul nebude problémy mít kvůli použité technice použít nejrychlejší režim Multi-GPU (AFR) a pak jsou tu jevy znemožňující použít SLI/CrossFire (nedej bože 3-way či Quad-) řešení v progamingu: microstuttering (nerovnoměrné zobrazování snímků) a input lag (zpoždění na vstupu).

To vše vám s jednočipovým řešením, paralelním pouze uvnitř v rámci jediného monolitického jádra, nehrozí. Nvidia u tohoto řešení chce určitě ještě nějaký rok zůstat, koneckonců výkon je až na výjimku v podobě Crysis dostatečný pro jakákoli nastavení a další zvýšení výkonu mohou přijít s novým výrobním procesem (Nvidia je teprve na 65 nm) či novými GDDR5. A docela vysoké přetaktování GTX 280 napovídá, že by při dobré konstelaci hvězd mohla Nvidia vytáhnout jinak prakticky stejnou Ultru.

GeForce 280 GTX je pro našince i díky silné koruně oproti předešlému highendu Nvidia docela stravitelné sousto. Cena pod 12 000 Kč s DPH při uvedení není rozhodně špatná, je dokonce o trochu nižší, než při uvedení ne až tolik přesvědčivé karty se dvěmi levnějšími GPU – GeForce 9800 GX2. Nečekám ale, že by měla rychle klesat. Při počtu jader GT200, jež se vejdou na 300mm wafer (105) a složitém 512bitovém PCB by asi Nvidia šla s cenou dolů jen velmi nerada. Donutit ji k tomu může jen případná povedenost RV770, resp. dvoučipové karty na tomto chystaném grafickém jádru od AMD postavené.

Když se přestaneme bavit jen o herním výkonu, máme tu celkově dobře vyladěný produkt: zahřívání je chladičem udrženo v rozumné míře, teplý vzduch foukán z bedny ven, hlučnost regulovatelného větráku i při standardu lze hodnotit rovněž kladně. Hned s prvními dodanými ovladači jsem nenarazil na jediný problém ani v jediné z 22 testovaných her. Navíc Nvidia pilně pracuje na tom, aby (nejen pro GeForce GTX 280) bylo co nejvíce aplikací CUDA. Superrychlý převod videa do H.264 nebo jen soutěžení ve Folding@home může přilákat další kupce, dalším marketingovým tahákem bude zanedlouho PhysX. Hardwarovou akceleraci fyziky realizované ve hrách tímto enginem dokáže Nvidia jistě brzy rozšířit i mimo 3DMark nebo Unreal 3 engine.

Nvidia GeForce GTX 280

+ vysoký výkon ve vysokém rozlišení

+ ve své třídě tiché chlazení

+ nízká spotřeba ve 2D (idle)

+ rezerva pro přetaktování, výkon po přetaktování

+ celkově vyladěný produkt

- v průměru horší v poměru cena/výkon než 9800 GX2 či HD 3870 X2

- vyžaduje 1× 6-pin a 1× 8-pin napájení

Za zapůjčení grafické karty Nvidia GeForce GTX 280 děkujeme společnosti Nvidia.

Za zapůjčení grafické karty Asus Radeon HD 3870 X2 TOP děkujeme společnosti Asus.

Za zapůjčení grafické karty Sapphire Radeon HD 3870 Toxic děkujeme společnosti Sapphire.

Nepřehlédněte:

- Megatest grafických karet: minirecenze

- Megatest grafických karet: herní testy a 3DMarky

- Megatest grafických karet: duely

- Megatest grafických karet: shrnutí

- Stručná verze testu grafických karet

Oproti původně zveřejněnému článku došlo k opravám grafů u her Assassin's Creed (opraven výkon Radeonu HD 3870 X2), Enemy Territory: Quake Wars, Bioschock, Medal of Honor: Airborne, Race Driver: GRID a Hellgate:London. Ve dvou případech jsem opravil svoje chyby měření, u GeForce 9800 GX2 jsem zkusil v některých hrát přes profil vynutit AFR a obraz byl bez chyb a výkon vyšší, u Radeonů jsem nainstaloval ovladače Catalyst 8.5 WHQL a přeměřil, co se dalo. Kde se výkon změnil k lepšímu, tam jsem opravoval, u 3870 X2 klesl výkon v ET: QW, ale zase přestal blikat (a být průhledný) tank. U Hellgate: London jsem v grafech sjednotil anti-aliasing u všech karet na Medium, v grafu s AA na Very High nechávám jen GeForce (Radeony jej nepodporují).