TPU znamená Tensor Processing Unit

a takto označený čip je speciálním procesorem navrženým

pro akceleraci softwaru TensorFlow, který Google používá pro

strojové učení a jeho aplikaci. Tento ASIC (nejde o FPGA,

ale skutečně na míru vyrobený čip) by tedy měl být uzpůsoben

pro rychlé a na energii úsporné provádění tenzorového

počtu. Výpočty na TPU mají dle Google velmi dobrou efektivitu, ve

srovnání se standardními řešeními je údajně až desetkrát

efektivnější (ale není přesně sděleno, zda se tím standardem

míní CPU, GPU či třeba i FPGA).

Google TPU (Tensor Processing Unit)

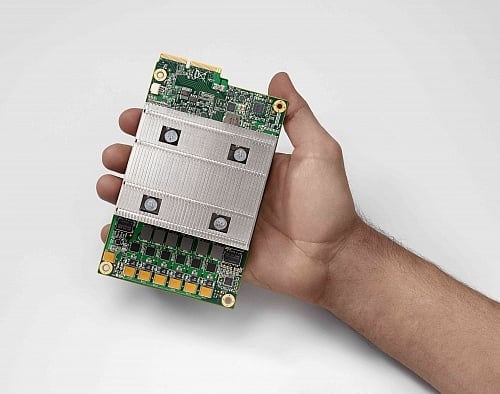

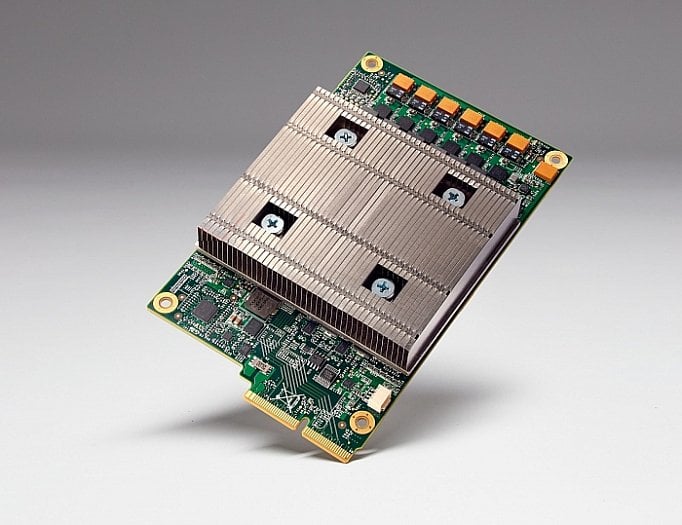

Fotky přímo čipu bohužel nemáme,

Google ukázal jen celý modul TPU s přišroubovaným pasivním

chladičem. Rozměrově je menší než výpočetní karty do PCI

Express, tento modul se údajně v rackových skříních vejde

do pozic pro disky, samozřejmě tam ale musí mít průvan pro

ochlazování pasivu. Spotřebu modulu ani jakékoliv další detaily

bohužel Google nepustil. Lze ale asi čekat, že jednotka komunikuje

přes nějakou sběrnici (PCI Express, CAPI, či něco speciálního)

s hostitelským CPU a hraje roli koprocesoru.

Jaká je architektura TPU, není známo.

Pravděpodobně bude mít vlastní instrukční sadu zvolenou na míru

a víme, že operuje se sníženou přesností kvůli omezení

spotřeby a hardwarové komplexity. Výpočty by prý měly

probíhat s pouze 8bitovými celočíselnými hodnotami, úlohy

umělé inteligence totiž obvykle nevyžadují přesnost FP32 či

vyšší, s kterou operují CPU i GPU. To, že se

nepoužívají výpočty v plovoucí řádové čárce, znamená

automaticky úsporu energie a vyšší výkon, celočíselné

operace jsou totiž obecně „levnější“.

TPU bude asi silně paralelní, a to

jak co do počtu „jader“, tak použití operací typu SIMD. Podle

AnandTechu zřejmě bude povaha hodně podobná obvodům DSP, možná

s architekturou VLIW. To by umožňovalo dosáhnout lepší

efektivity než s obecným GPU nebo FPGA.

TPU pohánějí služby Googlu již rok

Ačkoliv byl tento procesor (či

koprocesor) právě odhalen, není údajně zcela čerstvou novinkou.

Google totiž uvádí, že TPU již ve své infrastraktuře používá

po dobu delší než rok. Čip se tedy možná už vyrábí delší

dobu (pokud tedy není řeč o nějakém poloprodukčním

testování na raných inženýrských vzorcích). TPU byly údajně

nasazeny naostro necelý měsíc po otestování prvních kusů.

U Google z nich prý těží Street View či vyhledávací

algoritmus RankBrain. A co je zajímavé – TPU byly

údajně použity také v systému AlphaGo, který nedávno

„hrál“ proti

světovému šampionu v Go Lee Sedolovi. Z toho by snad

mohlo vyplývat, že TPU akceleruje aplikaci již naučené umělé

inteligence, spíše než její trénování (což jsou dvě různé

věci).

Racky systému AlphaGo, jenž podle Googlu také běžel na TPU

Ve sdělených informacích není nic

o tom, že by se TPU měla začít volně prodávat na trhu, zdá

se, že s nimi Google počítá hlavně pro vlastní použití

a bude si je schovávat jakožto zdroj konkurenční výhody pro

své služby. Je ale možné, že v následujících měsících

budou alespoň sděleny bližší podrobnosti o architektuře,

parametrech a výkonu.

Zdroje: Google,

AnandTech,

The

Platform