Google pořádal tento týden svou konferenci I/O 2018, na které se věnoval kromě svých různých aktivit patřících spíš pod software a služby jednomu ze svých hardwarových projektů – totiž AI procesorům TPU (Tensor Processing Unit). Google odhalil již třetí generaci označenou TPU 3.0. Google je v této oblasti hodně agresivní – první generaci čipu TPU odhalil před dvěma lety, druhou před rokem a s ročním odstupem má již třetí, která má opět zvýšit výkon.

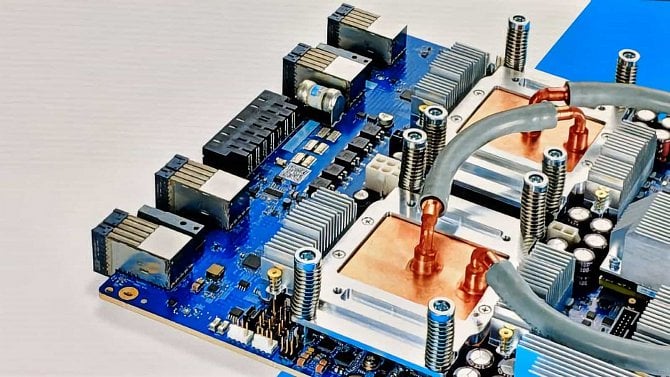

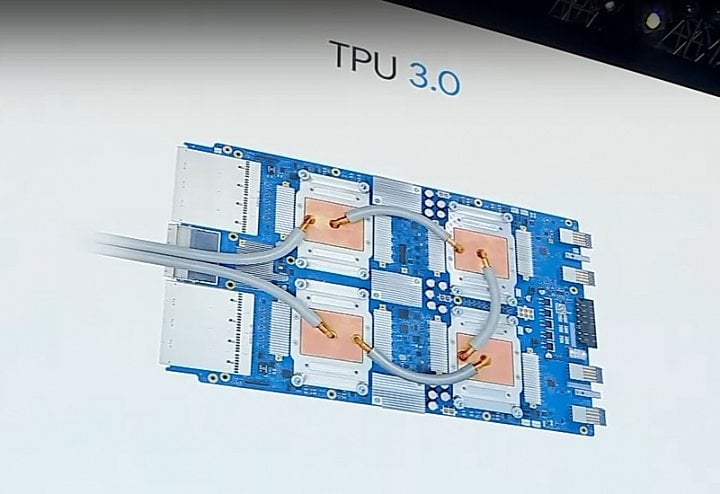

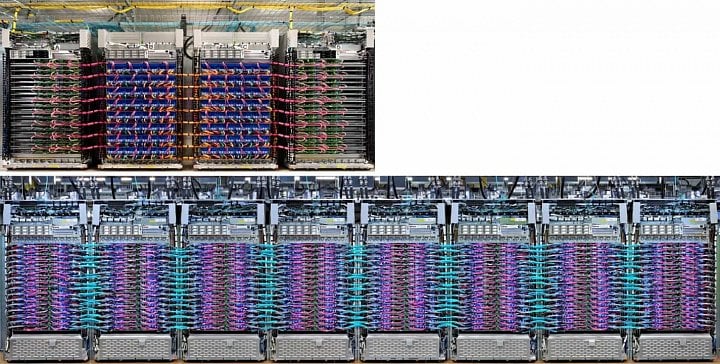

TPU Google jsou na rozdíl od hlavního konkurenta, jímž jsou GPU Tesla od Nvidie (nyní v 12nm generaci Volta), čipy specializované čistě na výpočty strojového učení, tedy „ASICy“. Druhá generace TPU slibovala výkon 180 TFLOPS, ovšem ve skutečnosti toto číslo udávalo výkon jedné desky, která byla založená na celkem čtyř čipech, na jeden z nich tedy připadalo 45 TFLOPS. Toto uspořádání je zřejmě zachováno i u TPU 3.0, které je také organizováno po čtyřech čipech na desce, přičemž jednotlivé desky jsou v datacentru propojené poměrně rozsáhlou konektivitou, viz kabeláž všudypřítomnou na fotografiích.

Google k TPU 3.0 bohužel sdělil jen minimum informací, ale zmínil, že má proti druhé generaci poskytovat „osminásobný výkon“ na jednu jednotku, kterou Google označuje „pod“. A jeden jeden pod má údajně vyvíjet výkon přes 100 PFLOPS (petaflops). Pro srovnání, pod složený z TPU 2.0 by prý měl mít výkon 11,5 PFLOPS, což by vycházelo na větší než osminásobný nárůst.

Vodní chlazení pro vyšší výkon

Jak se ale zdá, toto neznamená, že se osmkrát zvýšil výkon jednoho čipu TPU 3.0. Podle analýzy webu The Next Platform zřejmě Google jednak zdvojnásobil počet serverových racků (a tedy i místo zabrané v datacentru), z nichž je jeden pod složen. Zároveň je teď zdá se také dvakrát vyšší počet desek s čipy TPU 3.0, osazených v jednom racku. To je umožněno přechodem ze vzduchového na vodní chlazení, jež má výrazně nižší profil. Ono osminásobné (či ještě větší) navýšení výkonu jde tedy z velké části na vrub prostě zečtyřnásobení počtu ASICů v jednom podu.

To znamená, že samotné čipy TPU 3.0 by měly vyvíjet zhruba dvojnásobný výkon proti TPU 2.0. Google mohl přejít na menší výrobní proces a zvýšit frekvence, na nichž ASIC běží, případně přidat jednotky. Vzhledem k vodnímu chlazení je také možné, že bylo zvýšeno TDP, což by přímo zvyšovalo výkonnostní potenciál. Je také možné, že třetí generace TPU není nějakým výrazným architektonickým předělem, který by asi hrubý výkon v TFLOPS mohl posunout ještě víc, ale víceméně rozvinutím architektury z TPU 2.0 do „širší“ implementace s vyšším výkonem.

Podle The Next Platform by jeden pod čipů TPU 3.0 (dole) měl být složen ze dvojnásobného množství racků s deskami proti podům TPU 2.0 (nahoře), přičemž v racku je také dvakrát víc desek

Podle The Next Platform by jeden pod čipů TPU 3.0 (dole) měl být složen ze dvojnásobného množství racků s deskami proti podům TPU 2.0 (nahoře), přičemž v racku je také dvakrát víc desekDvojnásobný či vyšší výkon jednoho ASICu by znamenal 90 či více TFLOPS ve výpočtech neuronových sítí. Čip proti čipu by tedy řešení Googlu dosahovalo stále jen zhruba tří čtvrtin teoretického výkonu, který uvádí Nvidia pro jednu Teslu V100 za použití jejích specializovaných tensor cores. Otázka je, jakou roli sehraje konektivita a softwarová/programovací stránka (Google například používá vlastní optmalizovaný formát čísel FP16 s větším rozsahem), TPU 3.0 by ale asi mělo být nejvýkonnějším konkurentem Nvidie.

Cloud k pronájmu versus hardware na prodej

Google nicméně má zcela odlišný obchodní model než Nvidia, takže uvidíme, jak velká mezi nimi může na trhu „AI výpočtů“ – či lépe řečeno strojového učení – vůbec vzniknout konkurence. Zatímco Nvidia prodává hardware či v menší míře celé servery osazené výpočetními GPU, žádné z TPU nebylo zatím na prodej samostatně.

Google je zaměřen na model „as a service“ a případní uživatelé mají k jeho hardwaru přístup vždy jen vzdáleně jako ke cloudu. Nemohou ho také programovat přímo, ale jen skrze poskytnutý framework. Která z těchto možností je atraktivnější, to asi vědí jen konkrétní firmy v tomto byznysu, ale logicky by se dalo čekat, že tato politika Googlu dost omezí potenciál TPU 3.0 přetáhnout zákazníky od Nvidie.