Nvidia spustila svou každoroční výroční konferenci GTC. Šéf Jen-Hsun Huang na nich v poslední době obvykle prezentuje hlavně výpočetní a AI využití technologií Nvidie, takže se na těchto akcích obvykle nedá čekat odhalení nějakých nových herních grafik. Firma ale představila velmi zajímavé výpočetní GPU a zřejmě také vůbec nejvýkonnější GPU, jaké doteď bylo vyprodukováno: akcelerátor označený H100 NVL.

Nvidia H100 NVL je založená na čipu H100 „Hopper“ oznámeném loni. Jde ale o jeho výkonnější verzi, která poprvé používá plnou šířku paměťového řadiče. Základem je, zdá se, konfigurace H100 s 16 896 jednotkami FP32 alias shadery či CUDA jádry a 528 tensor jádry. Takty boostu patrně budou okolo 1,98 GHz, což jsou parametry běžného akcelerátoru Nvidia H100 v provedení SXM (zatímco verze pro slot PCIe je slabší).

Nová Nvidia H100 NVL používá ale místo 80GB paměti HBM3 již kapacitu 96 GB se 6144bitovou sběrnicí, takže propustnost by měla stoupnout z nějakých 3,35 TB/s na 3,9 TB/s.

To ale není to hlavní. Ono NVL v názvu znamená NVLink a akcelerátor H100 NVL jej využívá k propojení dvou těchto jednotek dohromady – propustnost komunikace mezi oběma GPU má být až 900 GB/s díky 18 linkám NVLink 4. Výsledkem je tedy akcelerátor se dvěma H100 po 16 896 shaderech s dvojnásobnou pamětí. Z nějakého důvodu Nvidia uvádí kombinovanou paměť nikoliv 192 GB, ale jen 188 GB. Je možné, že každé z GPU vyhrazuje 2 GB pro cachování dat v pamětí druhého GPU. Nebo může část kapacity být rezervovaná pro jiné účely, ale protože HBM3 se vyrábí v modulech po 16 GB, fyzická kapacita by měla být 192 GB.

Tento akcelerátor má být speciálně určený pro nejmodernější současnou AI s velkými modely jako GPT-3 a 4, kvůli jejichž velké paměťové náročnosti je právě sdružena maximální kapacita dvou GPU H100.

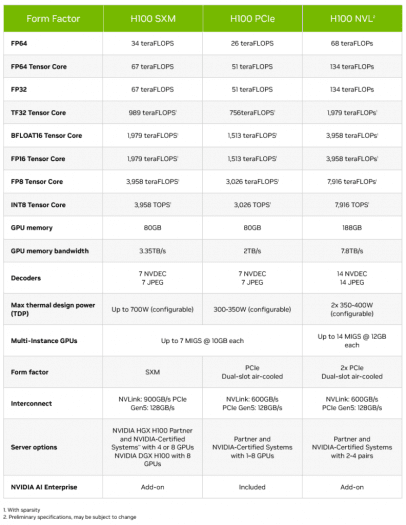

Nvidia uvádí, že tento celek má výkon až 134 TFLOPS v operacích FP32 a až 68 TFLOPS ve výpočtech s dvojitou přesností, tedy přesně dvojnásobek výkonu akcelerátoru H100 v provedení SXM5. Celkový výkon v tensor jader v maticových operacích pro AI je až 3958 TFLOPS v přesnosti FP16 nebo BFloat16 a až 7916 TOPS v INT8. Toto jsou údaje se započítanou technologií Sparsity, tedy nikoliv samotná fyzická výpočetní kapacita.

Je otázka, zda bude výkon opravdu přesně dvojnásobný. TDP je totiž uváděno jako konfigurovatelné mezi 350–400 W, ale to je patrně jen pro jedno z obou GPU, takže celkově jsme na 700–800 W. Naproti tomu jednoprocesorová verze H100 má sama o sobě TDP 700 W. Je možné, že v AI operacích není maximální TDP běžně využito. Ale pod maximální výpočetní zátěží zřejmě kvůli sníženému stropu spotřeby pojede akcelerátor H100 NVL na nižších frekvencích a jeho teoretický výkon tak ještě před započítáním nějakých neefektivit kvůli paralelizaci bude nižší než dvojnásobný proti jednočipové verzi, jak už to bývá.

Srovnání parametrů akcelerátorů Nvidia H100 v provedení SXM5, H100 v provedení PCIe a dvojčipové verze H100 NVL (zdroj: Nvidia)

Srovnání parametrů akcelerátorů Nvidia H100 v provedení SXM5, H100 v provedení PCIe a dvojčipové verze H100 NVL (zdroj: Nvidia)Čtyřslotová (dvou)karta PCI Express

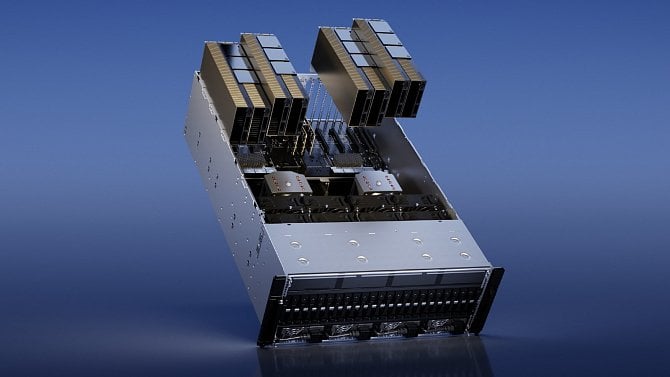

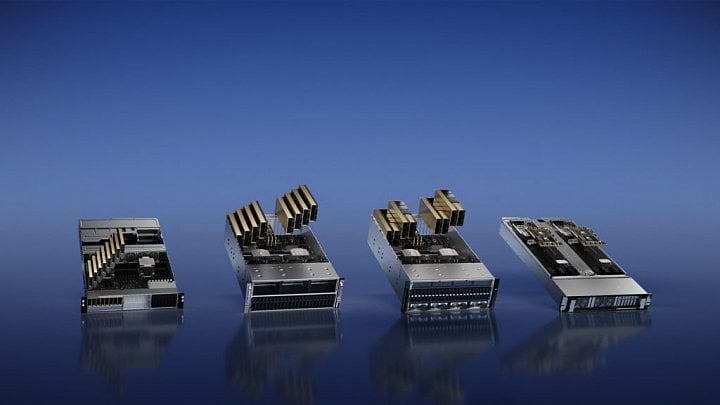

Zajímavé je fyzické řešení. Ačkoliv je H100 NVL až na to TDP ekvivalent dvou akcelerátorů H100 v provedení SXM5, nepoužívá toto mezaninové provedení, ale formu karty PCI Express ×16 s dvojslotovou šířkou. Ovšem tato karta nemá obě GPU na jednom PCB. Místo toho je celek H100 NVL tvořený dvěma těmito kartami vedle sebe, propojenými můstky NVLink. Akcelerátor tak zabírá čtyři sloty.

Zdá se tedy, že fyzické provedení tohoto akcelerátoru nepoužívá nějaký vyloženě nový návrh a PCB, ale zřejmě jde o desky a chladiče ze standardní PCIe verze H100, jen je Nvidia spojuje do páru. Ale jak již bylo řečeno, také na tyto karty místo více osekané verze (PCIe H100 má jen 14 592 shaderů) používá výkonnější konfiguraci nově s 96GB HBM3.

Odhalení sice bylo už nyní, ale podle prohlášení Nvidie budou tyto dvojité karty dostupné až v druhé polovině roku. Žádný oficiální údaj o ceně nebyl zveřejněn, bude ale velmi vysoká. Vedle toho, že jde o dvě GPU H100 najednou, bude určitě také nějaký příplatek za osazení plné kapacity paměti a za exkluzivitu tohoto vůbec nejvýkonnějšího modelu v nabídce.