Nvidia oficiálně představila grafickou kartu nazvanou prostě GeForce GTX Titan postavenou na výkonném jádře GK110. Předesílám, že by se dnes ještě neměly objevit výsledky testů, na ty je embargo až do 21. února. A také na naše testy budete muset počkat déle, s referenční kartou se na nás nedostalo.

Jak to měla Nvidia s grafickou kartou postavenou na nejvýkonnějším jádře původně naplánováno, se už asi nikdy nedozvíme. V krátkosti se pokusím shrnout pavlačové drby, „zaručené zprávy“ které tuto generaci Keplerů provázely, provázejí a provázet budou, a které se jako argumenty používají i v diskuzích na obou stranách. I ze strany marketingu jsme se dočkali řady překvapení, kotrmelců, a svébytného vidění světa. Neberte úvod jako historickou rekapitulaci ani popis toho, jak to mělo být doopravdy. Spoustu těchto tvrzení výrobci ani nijak nekomentovali, nebo komentovali „mimo záznam“, něco možná i rozporovali. Jak to tak bývá, pravda bude někde uprostřed.

Radeon HD 7970 s předstihem před konkurencí

Začalo to vlastně už uvedením konkurenčního Radeonu HD 7970, který byl uvedený se slušným předstihem proti prvním Keplerům. Nový model všechny překvapil poměrně nízkými takty jádra (a obrovským potenciálem pro přetaktování). Někdo tuto vlastnost prvních HD 7970 označuje za ostýchavost AMD uvést výkonnější kartu nebo zbytečnou skromnost, sám považuji tyto vlastnosti Radeonů za tehdy rozumný kompromis – žádný produkt, který by jí ve své době mohl konkurovat, na trhu nebyl, a relativně nízké takty umožnily uvést kartu s vysokým výkonem a dobrými provozními vlastnostmi. Výrobcům navíc zůstala možnost předvést, co umí, u přetaktovaných modelů. Tomu, že řada HD 7000 s novým výrobním procesem neměla plně srovnatelnou konkurenci, odpovídaly i nasazené ceny.

Sapphire Radeon HD 7970 GHz Edition Vapor-X se 6 GB paměti, jedna z nejlépe vybavených karet s Tahiti (recenze)

Za „skromnými“ parametry HD 7970 mohlo stát i to, co se kdysi (na základě tehdy „uniklých“ roadmap) tradovalo, totiž že Nvidia nedokáže na novém výrobním procesu zahájit prodeje nové generace karet jako obvykle největším highendovým GPU, ale s Keplery začne netradičně mainstreamem a aby mohlo aspoň nějak konkurovat výkonným Radeonům, highend „zalepí“ po vzoru AMD kartou se dvěma levnějšími čipy.

Byl první Kepler opravdu highend?

Cílení prvního „Keplera pro desktopy“ by ostatně odpovídalo téměř vše – levnější referenční design karet, parametry jádra, rozměry jádra, ořezání GPGPU části, označení jádra GK104 (číslo dosud používané u mainstreamu), šířka sběrnice, běžná kapacita grafické paměti, spotřeba, zkrátka GTX 680 se zdála být mainstream jako vyšitý, až na výkon, označení karty a cenu.

Leckdo měl už před uvedením prvních herních Keplerů o vítězi této generace karet tedy „jasno“ a Keplerům věštil temnou budoucnost. O tom, jestli někdo u Nvidie po zjištění výkonu Radeonů HD 7970 změnil na poslední chvíli plány a z mainstreamu udělal highend, už budeme moci asi jen spekulovat. S uvedením překonala oficiální GeForce GTX 680 ve většině testů oficiální HD 7970 nejen po stránce výkonu, ale i provozními vlastnostmi a s uvedením dokonce i poměrem cena/výkon. Obránci Radeonů tehdy měli několik protiargumentů – k ceně GTX 680 se dodávalo, že je sponzorovaná Nvidií jen na uvedení a časem podraží, říkalo se, že GTX 680 nemá na rozdíl od HD 7970 ten správný highendový čip, protože má část pro GPGPU osekanou a tak je podstatně pomalejší při výpočtech v double precision, a taky že GTX 680 je vyhnaná nadoraz, aby mohla Nvidia Radeonům HD 7970 aspoň nějak konkurovat.

Odpovědí AMD na první řady Keplerů bylo hromadné zlevňování konkurování lepším poměrem cena/výkon – pro někoho doklad toho, jak to s námi AMD myslí dobře a jak je zase a pořád lepší, pro někoho důkaz, že ceny Radeonů byly přestřelené, pro někoho jen logická odpověď v době, kdy dorazila pořádná konkurence.

Kepler, který předběhl…

Jakýmsi intermezzem bylo uvedení dvouprocesorové GeForce GTX 690, karty, která dosud ze strany samotného AMD nemá oficiálního konkurenta. V tomto ohledu se dá naopak říci, že Nvidia dobu předběhla. I když AMD avizovalo přípravu dvouprocesorových karet s Tahiti už od uvedení HD 7970, na webu AMD o HD 7990 zmínku nenajdete, neexistuje na stránkách podpory, v ovladačích, nikde. Nedozvíme se, jestli se práce na referenční HD 7990 zastavilo uvedení GTX 690, jestli její vývoj ustal poté, co nedočkaví výrobci začali představovat vlastní řešení, nebo zda se ještě přece jen náhodou oficiálně neobjeví (AMD v této souvislosti naposledy mluvilo jen o tom, že mají přijít i další modely HD 7990). Provozním vlastnostem GTX 690 by karta se dvěma čipy Tahiti při obdobném výkonu asi konkurovat nemohla, stejně tak je otázkou, jestli by mělo AMD odpověď na frame rate metering.

Modely označované jako HD 7990 nicméně vznikly alespoň v režii výrobců, opět nezodpovězená otázka je, nakolik se v celém procesu angažovalo samotné AMD. Minimálně marketing AMD je ale už v poslední prezentaci pro tisk bral za své (v pátečním konferenčním hovoru říká doslova: „Máme s Asusem nejvýkonnější grafickou kartu Ares II vypuštěnou před několika týdny“ a máme HD 7990), i na stránkách AMD už se dozvíte, že nejvýkonnější grafika nese čipy AMD (a na to, že se to ani s uvedením jednočipového Titanu nezmění, sází i AMD). Dvoučipové karty zmiňuji především proto, že jak to z vyjádření AMD vypadá, žádná odpověď na Titan se v dohledné době neobjeví a argumentem AMD budou právě „dvouprocesorové HD 7970 GE“.

AMD na GeForce GTX 680 posléze reagovalo uvedením kontroverzní HD 7970 GHz Edition. Pro některé to byla karta, která vypadala tak, jak mohla vypadat HD 7970, kdyby AMD nebylo tak skromné, protikladem je pak názor, že AMD šlo přes mrtvoly (rozuměj vysoká spotřeba) a z přetaktovaných modelů udělalo oficiální kartu jen proto, aby trumflo referenční GTX 680 a mohlo tvrdit, že má nejvýkonnější kartu. K tomu jen dovětek, přetaktované GeForce GTX 680 nejsou také ničím neobvyklým a uvést oficiálně nějakou „GeForce GTX 680 Ultra“ s vyššími takty by pro Nvidii asi nebyl problém, nicméně na uvedení HD 7970 GHz Edition nijak nereagovala.

AMD k Titanu

A nevraživost u obou táborů asi neskončí. Dnes jsme se dočkali oficiálního představení karty prostě označené jako GeForce GTX Titan. I u ní se můžeme připravit na řadu protichůdných argumentů.

Marketing AMD po šťourání redaktorů na téma „konkurence pro Titan“ při pátečním konferenčním hovoru (přepis v angličtině) původně svolaném na téma „ke spekulacím, že Radeony HD 8000 letos nebudou“ reagoval, že jde o kartu, která (podle dosud známých skutečností) neměla být nikdy herní grafikou a podle dosud zveřejněných výsledků nebude ani nejvýkonnější. GK110 je podle něj z jiného světa, jde o Teslu, která nebyla nikdy určená pro běžné spotřebitele a jde o snahu Nvidie za každou cenou pokořit nejlepší čip AMD. Při té příležitosti jsem se tedy s odkazem na citaci u Nvidie poptal, jak to vidí oni, ale odpověď na tvrzení AMD byla ještě stručnější, než jsem čekal: „Briefing AMD nekomentujeme.“

Můžu k tomu jen dodat, že z pohledu hráče se GTX Titan ničím neliší od dosud uvedených herních grafických karet a má vše, co herní GeForce mají, ba dokonce něco navíc – podporuje DirectX 11 (s hardwarovou implementací DirectX 11_0 a sw kompatibilitou s 11_1), podporuje i zapojení čtyř monitorů, podporuje 2-way i 3-way SLI a nabízí dokonce novou verzi GPU Boost označenou 2.0.

Ve finále máme tedy oba výrobce, kteří jsou se stávající situací tak nějak spokojení a razí svou pravdu (AMD argumentuje tím, že má nejlepší nabídku na všech cenových pozicích a Radeony se výborně prodávají, Nvidia rovněž tím, že je s GeForce spokojená a jdou na dračku) a už je nic netlačí zlevňovat ani uspíšit uvádění nové generace karet. Uvidíme, jestli na tom uvedení Titanu něco změní, s ohledem na avizovanou cenu ale dost možná vše zůstane při starém.

Nvidia: „GeForce GTX Titan: Nejrychlejší GPU na světě“

Podtitulek jsem si vypůjčil z dokumentace Nvidie. Oficiální parametry nové GeForce jsou už z útržkovitých zpráv a úniků (i na základě toho, že profi karty se stejným čipem už nějakou dobu existují) poměrně přesně známé. Už z parametrů jádra při srovnání s parametry a výkonem GTX 680 se dá vytušit, že s hrubou silou GK110 se teď bude moci jen stěží jiný GPU měřit. Bohužel tomu odpovídá i cílení a provedení samotné GeForce GTX Titan. Nvidia podobně jako u GTX 690 dává převahu karty najevo až moc okázale…

Představení karty, parametry, konstrukce

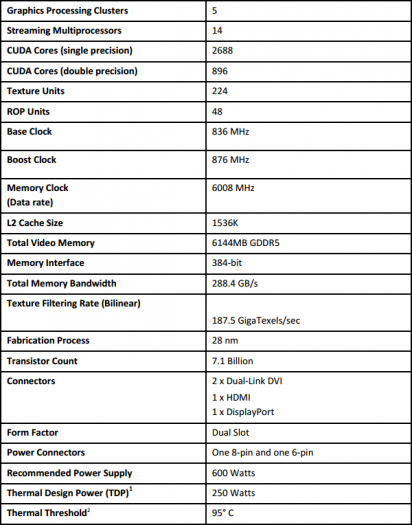

Karta nese jádro GK110 vyráběné 28nm procesem. Má 7,1 miliardy tranzistorů a výkon 4,5 TFLOPS. Oproti GTX 680 má o 75 % více stream procesorů, celkem 2688 pro výpočty v single precision a 896 pro výpočty v double precision. Dále je k dispozici 224 texturovacích jednotek a 48 rasterizačních jednotek. Výrazně nižší oproti GTX 680 je ale takt jádra – základní frekvence je 836 MHz a s GPU Boost se má pohybovat jen na 876 MHz.

Zatímco GeForce GTX 680 byla kritizovaná za to, že má standardně jen dnes už mainstreamové 2 GB paměti, u Titanu se netroškařilo. Karta nese šílených 6 GB GDDR5 na taktu 6008 MHz efektivně, které s jádrem komunikují po 384b sběrnici. Oproti GTX 680 tak dosahují o 50 % vyšší propustnosti (288,4 GB/s).

Důvodem jsou prý požadavky některých zákazníků, kteří u podobných karet touží po dostatečné výbavě pro vícemonitorová řešení (případně rozlišení 4K) a i když je to pro stávající hry zbytečnost, chtějí ji jako rezervu do budoucnosti.

Až neuvěřitelná je v kontrastu s obrovskými rozměry i parametry čipu spotřeba, zejména ve srovnání se 195W GeForce GTX 680 – uváděné maximum GTX Titan je jen 250 W. Zásluhu na tom bude mít i výrazně nižší takt GPU a možná i to, že jde o kartu, která se s ohledem na cenu asi nebude prodávat v masovém měřítku, takže lze vybírat vydařenější čipy s lepší spotřebou.

Karta má standardní formát 10,5" (asi 27 cm). Provedení je opět luxusní, podobně jakou u GTX 690 tvoří kryt stříbřitý kovový odlitek a nad žebrováním je „prosklené okno“.

Logo Titan po straně je stejně jako u GTX 690 podsvícené.

Plošný spoj má jen šestifázové napájení pro GPU, další dvě fáze jsou vyhrazené pro paměti. Podle Nvidie by ale mělo být dimenzování dostatečné i pro výrazné přetaktování, při interních testech se i s referenčním chladičem prý povedlo Nvidii v extrémních případech překonat i 1100 MHz.

Chlazení využívá ploché obdoby heatpipe – komory označované jako vapour chamber a speciální teplovodivé „pasty“ od společnosti Shin Etsu, která má prý více než dvojnásobnou tepelnou vodivost oproti pastě použité u GTX 680. K vyššímu výkonu chladiče má přispívat i to, že žebrování je na straně u ventilátoru delší než samotná základna. K lepšímu chlazení dalších součástek pomáhá i hliníkový rozvaděč tepla. Zajímavostí je ještě malý pasiv na opačné straně karty (s ohledem na fungování ventilátoru ale asi nebude ofukovaný).

Standardní jsou i výstupy, znamená to už v základu podporu hraní na třech monitorech zapojených přes DVI a HDMI. V tomto ohledu se karta tedy neliší od dříve uvedených herních Keplerů.

A ještě se podíváme na nové či vylepšené vlastnosti.

GPU Boost 2.0, přetaktování LCD a výkon v double precision na vyžádání

Výčet novinek a vlastností není rozsáhlý, protože jde o kartu využívající stávající architekturu a většinu vlastností zdědila po svých předchůdcích. Podíváme se tak spíše na rozdíly a novinky oproti stávajícím herním GeForce.

GPU Boost 2.0 podle teploty

Spolu s kartou představila Nvidia i technologii GPU Boost 2.0. U první generace GPU Boost prý Nvidia zjistila, že omezení výkonu karty spotřebou prý automatické přetaktování stále ještě zbytečně limituje. U Titanu se tak namísto „cílové spotřeby“ orientuje na „cílovou teplotu“ tak, aby teplota GPU zůstávala na 80 °C, přičemž ale stále bere ohledy i na spotřebu karty. Uživatel může limit pro přetaktování navýšit prostým navýšením cílové teploty.

Výhoda celého řešení je zřejmá – není zapotřebí nechávat tak velkou rezervu jako dosud pro hůře chlazené počítače, navíc s lepším chlazením dosáhnete vyššího výkonu, a nevýhoda také – výsledky testů mohou ještě více záviset na tom, jak byla karta při testování chlazená. Určitě se tomu budeme více věnovat, bude-li příležitost.

Uživatelé, kteří automatiku moc nemusí, by měli mít možnost upravit nastavení GPU Boost pomocí utility pro přetaktování tak, aby karta preferovala řízení taktů podle teploty i bez omezení ze strany spotřeby. Potom by se už nemělo podobně jako u první generace GPU Boost stávat, že i když by si karta dala říct i na vyšších takty, řízení spotřeby už ji výše nepustí. A konečně, větší volnost by měla být i u přetaktovaných modelů při práci s navýšeným napájecím napětím.

GPU Boost 2.0: Display Overclocking

Další novinkou, kterou Nvidia představila, je „přetaktování displejů“. Asi to zní šíleně, ale je to jednoduché. Většina LCD zobrazuje běžně frekvencí 60 Hz. Se zapnutou vertikální synchronizací jste ale odkázáni na pracovní frekvenci displeje. Většina displejů zvládne (někdy jen v rámci tolerance) i frekvenci vyšší.

V nastavení GeForce přibude možnost, jak snímkovou frekvenci i při zapnuté vertikální synchronizaci navýšit jednoduše zvýšením zobrazovací frekvence. Samozřejmě to bude vyžadovat zkoušení metodou pokus omyl a výsledek bude záviset jen na tom, co zvládne displej (nejčastěji než na vás vyskočí okno, že signál s touto frekvencí už nelze zobrazit).

Výkon v double precision na vyžádání

Za kontroverzní bude možná označená další novinka – zamykání výpočtů s double precision. Titan totiž nemá standardně v ovladačích povolené výpočty v double precision plnou rychlostí (naplno běží jen osmina jednotek). Důvod je prostý, díky tomu může zbytek jádra běžet na vyšších taktech a ve hrách, kde něco podobného není (minimálně zatím) zapotřebí, může běžet rychleji. Plného výkonu lze i tak dosáhnout změnou položky v nastavení. Po její aktivaci se sníží takt jádra, ale výpočty v double precision poběží plnou rychlostí. Změna nastavení probíhá bez restartu.

Cena... taky luxusní.

Oficiální cena má být 999 dolarů, měla by tedy být podobně exkluzivní jako u dvouprocesorové GTX 690. Zvěsti o tom, že by šlo o limitovanou edici karet, Nvidia v telefonické konferenci popřela. U nás čekejte v závislosti na výrobci částky převyšující 22 000 korun s daní.

To by bylo asi v kostce to základní, další pozornost budeme kartě samozřejmě věnovat s recenzí, jakmile se nám podaří uhnat některého z výrobců.