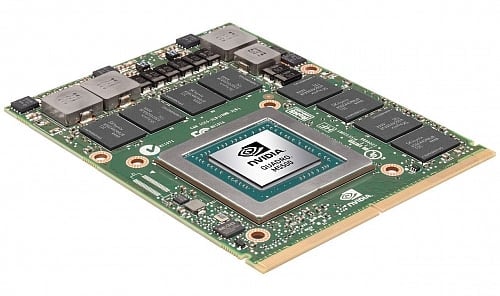

Quadro M5500 pro notebooky bude stejně

jako GTX 980 založené na plně aktivovaném Maxwellu GM204, takže

profesionální uživatelé potřebující certifikované ovladače

a podobné funkce nepřijdou proti hráčům zkrátka. Smyslem

tohoto modelu je zřejmě nabídnout GPU, které by vyhovělo

požadavkům VR brýlí HTC Vive a Oculus Rift, na které Quadro

M5000M výkonem nestačí. Quadro M5500 místo něj (výměnou za

těžší, hlučnější a žravější notebook) může

vývojářům či jiným profesionálům poskytnout GPU, které je na

virtuální realitu připravené.

Parametry nebude úplně lehké srovnat

se zmiňovanou GeForce GTX 980 pro notebooky. Pro tu totiž Nvidia

udává základní takt (1064 MHz), kdežto zde pro Quadro M5500 máme

zase jen údaj pro turbo, které má být okolo 1140 MHz. Čip GM204

zde zřejmě bude sešněrován omezeným TDP, takže pokud je u obou

nastavené na stejnou hodnotu, pak by asi měl být podobný i výkon.

Paměti GDDR5 má karta na docela vysoké efektivní frekvenci 6,6

GHz, ovšem to je menší takt než u GTX 980 (7,0 GHz) a měl

by na 256bitové sběrnici použitého GPU dávat propustnost 211

GB/s. Kapacita je 8 GB.

S touto konfigurací by karta měla

mít o 32 % lepší propustnost a až o 40 %

vyšší výkon než Quadro M5000M, které má 5,0GHz paměti GDDR5

a jádro ořezané na 1536 stream procesorů. Model M5500 ale

také asi bude adekvátně dražší. Přesnou cenu zatím neznáme,

podle dostupných informací se ale má karta v noteboocích

začít prodávat v květnu.

Quadro M5500 by se poprvé mělo

objevit v desktop (respektive asi spíš pracovní stanici)

nahrazujícím modelu MSI WT2, což bude skoro čtyřkilový stroj

s 17,3" obrazovkou a po stránce CPU vybavený

neupřesněným mobilním Xeonem E3-1500 v5 s architekturou

Skylake. Jelikož tento notebook bude přímo směřován vývojářům

se zájmem o virtuální realitu a kompatibilita s VR

brýlemi bude hlavní devizou, může to znamenat, že nebude mít

aktivní baterii šetřící technologii Nvidia Optimus pro přepínání

grafiky. Rift totiž kvůli latencím vyžaduje port HDMI vyvedený

přímo z aktivního GPU, notebooky používající Optimus jej

ale musí mít napojený na GPU v procesoru, což je pro latence

nevyhovující.

Zdroj: AnandTech