Rodokmen dnešních grafických čipů

Poté, co Nvidia i ATi vyrukovaly s grafickými akcelerátory podporujícími DirectX 10, se technologický vývoj téměř zastavil. Kořeny GeForce GTX 260/280 (G200) a Radeonů HD 4800 tedy najdeme u GeForce 8800 (G80), respektive u Radeonu HD 2900 XT (R600). Proto právě povídáním o těchto čipech začnu, ačkoliv se to na první pohled může zdát jako zbytečné opakování něčeho, co už bylo řečeno. Ale předem vás varuji, že přeskočení na poslední kapitolu článku, jak jste zvyklí to dělat u recenzí, zde nebude mít kýžený efekt. Mějte prosím také na paměti, že názory prezentované v tomto textu jsou často subjektivní.

Než se pustíte do čtení článku, pro osvěžení paměti a snadnější orientaci jsem sepsal časovou osu:

- říjen/október 2006: Nvidia vydává GeForce 8800 (G80) a usazuje se na technologickém i výkonnostím trůnu.

- květen/máj 2007: po dlouhém čekání vydává ATi Radeon HD 2900 XT (R600). Karta je terčem ostré kritiky a recenzenti i čtenáři ji považují přinejmenším za zklamání. Nvidia krátce na to vydává GeForce 8800 Ultra, ta ale s Radeonem nesoupeří a jedná se vlastně pouze o přetaktovanou GeForce 8800 GTX.

- září/september 2007: Nvidia vydává GeForce 8800 GT (G92) a způsobuje po téměř roce cenovou revoluci. ATi svižně vydává Radeony HD 3800 (RV670), výkonem a cenou se zařazuje pod novinky od Nvidie.

- leden/január 2008: ATi vypouští Radeon HD 3870 X2. Jelikož jde o CrossFire na jedné kartě, názory se různí, ale v testech výkonu dvoučipový Radeon zpravidla poráží jednočipové GeForce.

- březen/marec 2008: přichází GeForce 9800 GX2, očekávaný vyzyvatel – a pokořitel – Radeonu HD 3870 X2.

- červen/jún 2008: Nvidia vydává GeForce GTX 260/280 založené na novém jádře G200, ATi v rychlém sledu osvěžuje nižší mainstream čipem RV770 a Radeony HD 4800.

První vlna: G80 a R600

GeForce 8800: recept na úspěch

Jádro G80 přišlo na trh prakticky jako atomová bomba z čistého nebe. Po mediální kamufláži Nvidie a dlouhých letech, kdy leaderem byla ATi, se od G80 příliš mnoho neočekávalo. Právě to byla ideální atmosféra pro příchod legendy. Ačkoliv se v době vydání ozývaly skeptické hlasy, že v Direct3D 10 se ukáží nedostatky čipu laděného převážně pro Direct3D 9, tyto obavy se během jeho životnosti nepotvrdily a G80 tedy po více než roce odešla do důchodu prakticky neporažená (když nepočítáme dvoučipový Radeon HD 3870 X2). Budete se mnou jistě souhlasit, že G80 se může zařadit do síně slávy po bok tak slavných GPU, jako byl například R300 od ATi (Radeon 9700).

Největší inovací a hlavní zbraní G80 byly unifikované stream procesory, které dokázaly běžet na frekvenci více než dvakrát vyšší, než zbytek čipu. Silný byl i blok texturovacích jednotek a to celé bylo podpořeno vysokou propustností pamětí, kterou zajistila do té doby nevídaně široká 384bitová sběrnice. A hlavním tahákem prodejů, i když nevyužitelným, byla již zmiňovaná podpora DX10.

„Podpora Direct3D 10 z ní činila velmi vydařený produkt.“

Kritici G80 zdůrazňovali, že mnoho dílčích technologií implementovala ATi již u čipů série R5xx nebo dokonce dříve. Jenže jak už to tak bývá, jedna firma něco vymyslí, a teprve konkurence to převezme a dotáhne k dokonalosti (například monolitické čtyřjádro s integrovaným paměťovým řadičem a rychlou sériovou sběrnicí, ale to odbíhám). G80 k technologiím přidávala na svou dobu nevídaný výkon a třešnička na dortu v podobě podpory Direct3D 10 z ní činila velmi vydařený produkt.

Příznivci ATi ale už od počátku hovořili o mračnech, které se nad G80 měla stahovat. Ta mračna se jmenovala R600.

Radeon HD 2900: Godot se ztratil ve slepé uličce

GeForce 8800 netrpělivě čekala na vyzyvatele, jenže červené mračno jaksi nepřicházelo a nepřicházelo. Ani v březnu, kdy podle dlouhodobého plánu měl vyjít nový high-end, neměla ATi nic, čím by mohla soupeřit s G80. Až koncem května jsme se konečně dočkali. Jenže na bedra R600 byla kladena tak vysoká očekávání, která GPU zkrátka nedokázalo splnit.

„Na papíře vypadala nadějně.“

Nevěděli jsme, co můžeme od nové architektury očekávat a 320 stream processorů, byť uspořádaných jako 64 5D jednotek s taktem shodným se zbytkem čipu, vypadalo na papíře nadějně. Částečně se vycházelo také z předpokladu, že když už nás ATi nechala čekat tak dlouho, konkurenční high-endový čip překoná. Kromě již zmíněných stream processorů k tomu měla další dobré předpoklady: zkušenosti s unifikovanými shadery z Xenosu, modernější 80nm výrobní proces, vyšší počet tranzistorů a dosud nevídaně široká 512bitová sběrnice pro paměti.

Jenže Radeon HD 2900 XT sotva držel krok s GeForce 8800 GTS, očesanou verzí G80. Přitom měl vyšší spotřebu, abnormálně hlučný chladič a ačkoliv ATi upravila cenu tak, že poměr cena/výkon nebyl vyloženě špatný, vysoká očekávání způsobila, že téměř všichni označili R600 za jednoznačný propadák.

„Na neúspěchu R600 se podílelo hned několik pochybení. A mohlo to být i horší.“

Co se pokazilo? Někteří svalovali vinu za neúspěch R600 čistě na TSMC, které jednak nedokázalo poskytnout 80nm proces optimalizovaný pro vysoké frekvence včas a když už jej poskytnout dokázalo, trpěl výrobní postup vysokými úniky proudu. To znamená vyšší spotřebu, teplo, nižší dosažitelné takty, a problém je na světě. Pravdou ale je, že na neúspěchu R600 se podílelo hned několik pochybení.

Kromě TSMC chybovala samotná ATi, když narozdíl od Nvidie vůbec neodhadla podobu herního trhu v době životnosti karty. A mohlo to být i horší, podle původního plánu měl R600 být vydán už v srpnu/auguste roku 2006, ještě dříve, než G80.

„Byla technologicky pokročilá až příliš.“

Mnozí přirovnávali R600 k NV30 (GeForce FX 5800), která se do srdcí hardwarových nadšenců zapsala jako největší fiasko v dějinách grafických akcelerátorů. Risk s neozkoušeným výrobním procesem, vysoká spotřeba, hlučný chladič, neoslnivý výkon, vydání později než konkurence – ve všech těchto ohledech se R600 a NV30 podobaly. NV30 ale krom toho zaostávala také technologicky, takže se ani na architektuře nedalo příliš stavět. R600 naopak byla technologicky pokročilá až příliš a zastávám teorii, že 700 milionů tranzistorů by bývalo mohlo být lépe využito na čip vycházející z R580 (pak by sice neoplýval úžasnými technologiemi, ale po stránce výkonu by mohl lehce soupeřit s G80).

ATi se rozhodla jít jinou cestou a Radeon HD 2900 XT skončil jako velké zklamání. Přesto však všechno zlé bylo k něčemu dobré i v tomto případě. Jak se nyní ukazuje, architektura čipu R600 byla navržena s ohledem na velkou flexibilitu a škálovatelnost. A tak ačkoliv Radeonu HD 2900 XT jako produktu už navždy zůstane nálepka „propadák“, na R600 se poslední dobou začíná nahlížet trochu jiným, shovívavějším dojmem.

Intermezzo: G92 a RV670

Mírný pokrok v mezích zákona

Kdyby vás to zajímalo, toto slovní spojení pochází z názvu politické strany, kterou založil spisovatel Jaroslav Hašek. Budete asi oprávněně namítat, že příchod GeForce 8800 GT a později Radeonů HD 3800 byla záležitost poměrně revoluční, zejména z hlediska cen, za jaké se najednou daly pořídit karty, které podávaly výkon na úrovni starého high-endu.

„Projevila se zde flexibilita architektury.“

Z hlediska architektury se ale žádné velké změny neodehrály, nehledě na to, že ATi vytáhla z rukávu podporu Direct3D 10.1. Zde se totiž projevila již zmíněná flexibilita architektury R6xx a připravenost na implementaci dílčích technologií, které byly v ještě před uzavřením požadavků pro Direct3D 10 nepovinné. Chválu ale jádro RV670 sklidilo zejména za nízkou spotřebu v nečinnosti a celkově úsporný provoz díky tehdy zbrusu novému 55nm výrobnímu procesu. Dobrý dojem pramenil i z toho, že se ATi po neúspěchu s R600 dokázala celkem rychle oklepat. Mírné zklamání panovalo pouze ohledně výkonu, protože ani 55nm výroba neumožnila porazit G92 po stránce výkonu.

Nvidia si ale na úspěšnost G92 rozhodně nemohla stěžovat: ještě několik měsíců po vydání karty nebyly téměř k sehnání, jak šly na dračku.

V té době panovalo přesvědčení, že Nvidia dosahuje tak dobrých výkonů díky asynchronně taktovaným shaderům. Je veřejným tajemstvím, že shadery dosahují vysokých taktů díky manuálním úpravám designu čipu, které provádí jeden bývalý inženýr AMD. Proto někteří předpokládali, že ATi, kterážto už tenkrát byla rok v područí AMD, by tuto výhodu v budoucnu mohla vyčerpat také a Nvidia už by neměla čím odpovědět. Ve světle nových skutečností se ale i tento názor začíná přehodnocovat.

„Ortonův“ čip s 96 ALUs

O tomto mýtickém čipu jsem se zmínil v článku věnovaném Radeonům HD 4800, leč jsem tento pojem možná úplně nevysvětlil. Pochází z tohoto videa a někteří (například kolega Jirka Souček) věřili, že je to jasná zpráva o budoucnosti.

„R600 měla být předskokan.“

Dave Orton, tehdejší generální ředitel ATi, pronesl toto číslo ještě v době, kdy R600 nebyl na trhu. Když vyšlo najevo, že R600 má shaderů pouze 64, předpokládalo se, že počet 96 patří jeho následovníku, R650. Zřejmě ATi plánovala podobný postup, jako s R520 a R580. R600 měla hrát roli jakéhosi předskokana a až R650 měla být skutečnou bombou.

Plány se ale změnily a ATi v té době začala prosazovat, že budoucnost (alespoň high-endu) patří grafickým akcelerátorům s více čipy. Proto byl vývoj R650 pozastaven a vlajkovou lodí se stal katamarán Radeon HD 3870 X2. Sám Jen-Hsun Huang, generální ředitel Nvidie, ještě před vydáním GeForce 9800 GX2 prohlásil, že karty se dvěma GPU jsou pouze krajním řešením a že bude vždy preferovat velká monolitická GPU.

Žhavé novinky: G200 a RV770

Děkuji všem, kdo poctivě přelouskali předchozí dějepisné povídání. A doufám, že vám to pomůže k lepšímu chápání současné situace. Ještě než se pustím do samotného rozboru – nejspíš očekáváte, že budu hanit novinky od Nvidie a nesouhlasit tak s názory Mirka Jahody vyjádřenými v jeho glose. Ale možná čekáte něco jiného, než se tu skutečně dočtete. Například pod odstavec týkající se relevance plochy a odhadované výtěžnosti čipů pro koncového zákazníka, nebo srovnávání mainstreamu a high-endu, bych se s radostí podepsal. Tak jako ale některé věci nemusí zajímat zákazníky, pro ATi a Nvidii jsou velmi důležité a i na jejich základě může být vybrán směr, kterým se vývoj grafických jader bude nadále ubírat.

Goliáš 200

Dlouho se nevědělo, kdy bude vlastně nový high-endový čip od Nvidie vydán. V každém případě se od něj ale očekávaly velké věci. Pokud jsem přirovnal G80 k R300, G200 by měla být jako R420 – vycházet z osvědčené architektury, být mírně technologicky pozadu, ale jednoznačně si přivlastnit korunu výkonnostního krále.

„Image poškodila velká očekávání.“

Byla to právě velká očekávání, která zřejmě image GeForce GTX 280 uškodila. Ačkoliv karta netrpí problémy multi-GPU řešení jako GeForce 9800 GX2, kterou nahrazuje, v testech výkonu je často pomalejší. Kromě případů, kdy dvoučipové kartě nestačí 512MB paměť, si GeForce GTX 280 nedokáže obhájit svou cenu. To asi nejvíce zajímá zákazníky. Domnívám se ale, že ani Jen-Hsun Huang si GeForce GTX nevystaví na čestné místo ve své pracovně.

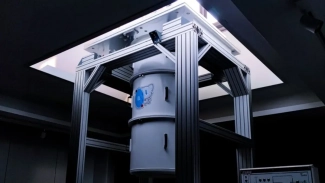

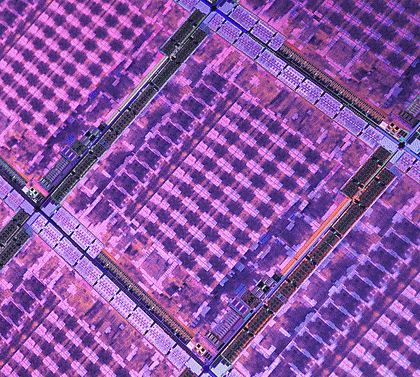

Že je G200 nejvýkonnější GPU na světě, je bez debat. Ale za jakou cenu? Čip nese 1,4 miliardy tranzistorů, zabírá plochu 576 mm2 a i když přesná čísla se vždy odhadují těžko, je pravděpodobné, že výroba takového čipu není zrovna laciná záležitost. Nemusíme ani chodit ke konkurenci, abychom viděli, že vyrobit dva čipy G92 (zvláště po die-shrinku na 55nm výrobu) je levnější a SLI podává vyšší výkon. Nemluvě o frekvenčních rezervách, které 55nm G92b má a které Nvidia nechává zčásti nevyužité.

„Na spotřebu a odpadní teplo zákazníci tolik nehledí.“

G200 je také dalším příkladem systému „jeden vymýšlí, druhý vylepšuje“: Nvidii se u G200 podařilo srazit spotřebu v nečinnosti až na úroveň slabšího čipu ATi RV770 (u kterého technologie PowerPlay zřejmě byla beze změn převzata z RV670) a chladič nemá problémy udržet kartu na rozumných teplotách ani v zátěži. Jenže to koneckonců byla sama Nvidia, která (v době vydání GeForce 9800 GX2) připustila, že pokud je produkt jednoznačně nejvýkonnější na trhu, na spotřebu a odpadní teplo už zákazníci tolik nehledí.

RV770: co nám to vyrostlo z ošklivého kačátka?

Kdo jste sledovali zprávy o G200 a RV770, když bylo vydání ještě v nedohlednu, jistě si vzpomenete, co se od obou čipů přibližně očekávalo. U G200 jsem o tom již hovořil. ATi byla mnohými považována za outsidera a nikdo nevěřil, že by duální RV770 (označovaná jako R700) mohla porazit chystanou GeForce, kterou jsme běžně titulovali přídomky jako „trhač asfaltu“. I já jsem předpokládal, že RV770 těsně porazí G92, ale R700 bude soupeřit s očesanou verzí G200.

„RV770 zvládla svůj úkol na výbornou.“

Právě atmosféra nízkých očekávání byla ideální pro příchod velmi vydařeného čipu. Nebylo těžké splnit a předčit naše očekávání. Pokud cílem bylo porazit G92 a G80, pak RV770 tento úkol zvládla na výbornou – GeForce 8800 GTX a 9800 GTX totiž porazila i pomalejší z nových karet ATi, Radeon HD 4850.

Před vydáním jsme dlouho nevěděli, zdali bude v jádře přítomno 96, či 160 shaderů. Nakonec je to 160 (a tedy 800 stream processorů), kam se ale poděl „Ortonův“ čip? Na Beyond3D fóru se před pár dny mluvilo o tom, že RV770 byl původně navrhován s 96 ALUs, zároveň se ale pracovalo na úspoře místa. A to velmi úspěšně, výsledný čip byl příliš malý a nevešly by se na něj všechny potřebné kontaktní plošky. Proto prý inženýři „museli“ do jádra umístit více shaderů a texturovacích jednotek, než se původně plánovalo.

„Zároveň ATi zbořila mýtus.“

Zde se opět projevila flexibilita architektury R600 a připravenost pro škálování na výkonnější čipy (to se zřejmě týká hlavně řídících obvodů, jejichž složitost roste méně než úměrně s počtem výpočetních jednotek). Zároveň ATi zbořila mýtus, že nezávisle taktované shadery jsou jasná výhoda. Výpočetní jednotky ATi sice nedosahují tak optimálního vytížení, jsou ale velmi nenáročné na počet tranzistorů. Aby nakonec v nevýhodě nebyla Nvidia, jejíž shadery vlastně visí na jednom člověku a s vyšším počtem jednotek v čipu pravděpodobně roste časová náročnost jeho práce.

Jablka a hrušky?

GeForce GTX 260/280 jsem doposud ze srovnání s Radeony HD 4800 vynechával. Přeci jen, u high-endu se příliš nehledí na poměr výkon/cena a proto zpravidla nedává velký smysl porovnávat karty z výrazně odlišných cenových kategorií. Když ale GeForce GTX 260, která stojí kolem 7400 Kč s daní, zdatně konkuruje výrazně levnější Radeon HD 4870 (ještě není dostupný, ale jeho ceny by měly začínat už na 5200 Kč), srovnávání se asi těžko ubráníte. A nemáte-li pokřivené vidění světa, musíte nutně dojít k názoru, že GeForce GTX 260 je špatná karta. Právě ona si zaslouží označení „fiasko“, které jsem původně použít nechtěl, ale když už mi ho Mirek vložil do úst, budiž tomu tak. Nvidia samozřejmě může cenu snížit, ale stejně tak mohla před rokem zlevnit GeForce 8600 GTS a tehdy zjevně převážila chamtivost. Jako nové Radeony sráží špatné chladiče, nové GeForce GTX (a zejména model 260) diskvalifikuje vysoká cena.

„Stejně dobře poslouží GeForce 9800 GX2.“

Co se týče GeForce GTX 280, u té si zákazník připlácí za nejvýkonnější jednočipové grafické řešení, se kterým se nemusí bát problémů se škálováním SLI/CrossFire. Pokud ale nejste citliví na micro-stuttering a zpoždění obrazu o jeden snímek oproti jednočipové kartě a vlastníte LCD panel s rozlišením 1680 × 1050 nebo 1920 × 1200 pixelů, stejně dobře a v mnoha případech i lépe poslouží GeForce 9800 GX2. Ovladače pro SLI jsou v dnešní době velmi vyspělé, problémy se škálováním méně časté, než u konkurenčního CrossFire, a v neposlední řadě je dvoučipová karta levnější (asi o 2000 Kč). Ve prospěch GeForce GTX 280 hovoří výkon v rozlišení 2560 × 1600 a možnost si i zde zapnout anti-aliasing, ale užíváním tohoto argumentu odsuzujeme kartu do velmi malého segmentu trhu uživatelů, kteří vlastní nebo si hodlají pořídit 30" LCD panel.

Mirek: K těm kompromisům GeForce 9800 GX2 je zcela jistě potřeba přičíst když ne spotřebu, tak alespoň vysokou hlučnost (a obtížné chlazení). Pak se prostě cenová výhodnost maže. Něco jiného jsou dvě 9800 GTX ve SLI, nebo dva HD 4850 v CrossFire. To už jsme ale jinde.

I když si GeForce GTX 280 zachová atraktivitu jako nejvýkonnější grafická karta s jedním čipem, jsem přesvědčen, že Nvidia od jádra mamutích rozměrů očekávala lepší výsledek. Na pováženou je také půlroční zpoždění oproti prapůvodnímu plánu vydat kartu rok po GeForce 8800, tedy koncem roku 2007. G200 se vyrábí osvědčeným 65nm postupem, na výrobní technologii se tedy nečekalo. Že by se Nvidia snažila vylepšit výtěžnost a dosažitelné frekvence? O tom můžeme bohužel jen spekulovat.

Blízká budoucnost: R700 a... G200b?

Monolitické jádro vs. multi-GPU

David Kirk, hlavní inženýr Nvidie, se domnívá, že ATi prosazuje cestu multi-GPU proto, že nemá peníze na vývoj vlastního velkého monolitického čipu. Rick Bergman, ředitel grafické a multimediální divize AMD, se naopak nechal slyšet, že po G200 se i Nvidia vydá dvoučipovou cestou.

„Správný dinosaurus by měl být technologicky pozadu.“

Někteří příznivci ATi označují G200 za dinosaura. Zaslouží si toto označení? V současné situaci, kdy vyšší výkon podají dva menší a levnější čipy v multi-GPU režimu (ať už mluvíme o G92/b nebo RV770), se tento pojem silně podbízí. Netroufl bych si ale pojmenovat G200 dinosaurem pouze na základě výkonu. Na to mám jiné argumenty.

Správný dinosaurus by měl být technologicky pozadu, pokud tedy za zaostalou nepovažujete už samotnou koncepci velkého monolitického čipu. Architektura vycházející z G80 je jednoznačně starší než architektura současných čipů ATi. Pokud bychom měli hledat typický dinosauří prvek, bude to asi paměťový řadič. Zatímco ATi postupně přešla na ring-bus a nyní jej vyměnila za hub, Nvidia stále používá roky starý crossbar. Jeho problém tkví v tom, že se šířkou sběrnice roste jeho složitost nikoliv lineárně, ale kvadraticky, takže 512bitová sběrnice G200 nebude tranzistorově levná záležitost.

Co se práce s pamětí týče, tam má ATi vůbec navrch, ačkoliv důvod pro mne zůstává záhadou. Ve hrách a nastaveních, kde GeForce 8800 GT nestačí 256 MB, Radeon HD 3850 podává vyšší výkon a podobný jev se ve vysokých rozlišeních s anti-aliasingem opakuje u GeForce 9800 GX2 a Radeonu HD 3870 X2.

R700: obyčejné CrossFire, nebo něco víc?

O Radeonu HD 4870 X2 kolovaly spekulace, že by karta mohla mít sdílenou grafickou paměť, tomu ale příliš nevěřím. Jiné zdroje zase tvrdily, že Radeon HD 4870 X2 nebude trpět micro-stutteringem. Materiály ATi hovoří o vylepšeném CrossFire propojení, dost možná to souvisí se zmíněným hubem, případně i s PCI Express můstkem s podporou rychlejšího PCIe 2.0. Uspokojivé odpovědi by mohl poskytnout i test obyčejného CrossFire se dvěma Radeony HD 4800, ale aby náš šéfredaktor překonal odpor k multi-GPU systémům, museli byste být v diskuzi asi hodně hluční.

Mirek: Pokud bude diskuze obsahovat zkušenosti desítek majitelů CrossFire řešení a jejich příjemné zkušenosti se škálováním v méně známých (ne typicky testovacích) a přitom náročnějších hrách, bude to určitě lepší než jakákoli obrazná hlučnost. Stejně tak by mě zajímaly postřehy majitelů CrossFire co se týče snadnosti zapnutí CrossFire, nečekání na nový ovladač apod. CrossFire dvou RV770, stejně jako SLI dvou G200, budeme určitě testovat a upřímně budu rád, když uvidím, že u výrobců dochází k evoluci.

„Nvidia nebude jen nečinně přihlížet.“

Je ale už téměř jasné, že Radeon HD 4870 X2 porazí GeForce GTX 280 a nemusel by být ani o tolik dražší (pochopitelně bude záležet na tom, jakou si ATi nechá marži). Stejně tak je jasné, že Nvidia nebude jen nečinně přihlížet, jak je její vlajková loď torpédována – očekávejte, že z kalifornských loděnic v tu pravou chvíli vypluje G200b, 55nm verze G200. Zvýšení frekvenčního stropu, který přechod na 55nm technologii přinesl G92, je rozhodně zajímavým příslibem.

ATi má ale v poslední době talent na zlevňování svého hardware tak, aby nikdy nebyl nevýhodný. Proto se o osud Radeonu HD 4870 X2 nebojím. ATi jím dokáže, že i v high-endu se s ní musí stále počítat, a případný neúspěch duální karty ji nezasáhne tak, jako by Nvidii zasáhl neúspěch G200. Pilířem prodejů jádra RV770 totiž vždy bude mainstream.

„ATi postavila z jednoho čipu celou řadu.“

Již několikrát jsem v tomto článku použil přirovnání k R300 jakožto prototypu úspěšného čipu a k NV30 jako přesnému opaku. Také u RV770 najdeme jisté vlastnosti jeho legendárního předka. Kromě toho, že od R300 se také mnoho nečekalo a ATi (nebo spíše ArtX?) nakonec všechny překvapila, tehdy červení prakticky postavili z jednoho čipu celou řadu: Radeony 9700 pro high-end, Radeony 9500 (částečně zamčená jádra R300) pro mainstream, pro low-endové Radeony 9000 ATi oprášila čip minulé generace RV250. Nyní to bude podobné: 2× RV770 pro high-end, RV770 pro mainstream a RV670 pro low-end. Takto může ATi soustředit větší úsilí do jednotlivých čipů a příliš netříštit své designérské týmy.

Komu patří budoucnost?

Ačkoliv jsem v dobách GeForce 6 a 7, kdy SLI bylo na trhu teprve krátce, kritizoval jeho prosazování do nižších tříd (neboť s kartami jako GeForce 6200, 6600 nebo 7600 zkrátka nemělo význam), nyní se poměry na trhu obrátily a multi-GPU s levnými kartami je výhodnější. Proto jsem přesvědčen, že v budoucnu se vícečipové karty ukáží jako schůdnější řešení. U Radeonu HD 3870 X2 to nebylo příliš vidět, možná to nebude vidět ani u této generace, ale v budoucnu dle mého názoru lepší cesta neexistuje.

Nepředpokládám, že by v dohledné době „hrozila“ karta osazená více než dvěma GPU. Vývoj, který nás čeká, bude spočívat zejména ve zlepšování ovladačů a lepší spolupráce s herními vývojáři, aby se nestávalo, že SLI, CrossFire nebo obojí v nějaké hře nebude fungovat. Budou také snahy o eliminaci všemožných problémů s multi-GPU systémy, pracovat se bude na snížení „režijních nákladů“ (overhead) a zlepšení škálování, bude se zkoumat možnost sdílené grafické paměti, budou se dále vyvíjet technologie úspory energie. Právě spotřeba a z toho plynoucí hlučný chladič bude pravděpodobně trápit i chystaný Radeon HD 4870 X2 a na alternativní chladiče nelze příliš spoléhat. Když ale budou za rozumné ceny dostupné základní desky s čipsetem Intel P45, nic vám nebrání do nového počítače pořídit dva jednočipové Radeony.

„S high-endovou kartou si kupte i kýbl na nervy.“

Pokud z trhu vymizí high-endové monolitické čipy, nelze vyloučit, že experimenty s multi-GPU systémy negativně dopadnou právě na uživatele. Ještě dlouho tu budou problémy s funkčností SLI/CrossFire v některých hrách (zejména v těch, které se netestují na hardwarových webech, ale nezřídka i v nich), micro-stuttering… zkrátka si společně s high-endovou kartou kupte i pořádně velký kýbl na nervy. Dožili jsme se ale doby, kdy multi-GPU systémy neznamenají jen extrémní výkon za ještě extrémnější cenu. Multi-GPU řešení mění podobu trhu s grafickými akcelerátory, jsou tady a musí se s nimi počítat. Neobstojí přirovnávání monolitických čipů k automobilům – alespoň ne takové, jaké používají někteří čtenáři v diskuzi.

Veškerý odpor je marný.

Věřím, že mnoho z vás bude těžce nést přechod od monolitických čipů k multi-GPU řešením, podobně jako na první dvoujádrové procesory doléhala kritika. Dodnes si vzpomínám na článek Petra Orla, kde guru přes procesory označil vícejádrové procesory za slepou vývojovou větev a prorokoval jim brzkou zkázu. Nestalo se a přestože programátoři zpočátku nebyli zrovna nadšení z nutnosti programovat vícevláknově, nyní už vícejádrové procesory každý považuje za samozřejmost.

Mé poděkování na závěr tentokrát patří ATi a Nvidii, neb nás stále baví svými žabomyšími válkami, a Jirkovi Součkovi, který mě přivedl na mnoho nápadů pro tento článek.