Nvidia totiž připravuje nejen o trochu, ale zřejmě o dost výkonnější model, kterým nejspíš definitivně utvrdí pochybovače v tom, kdo bude mít u stávající generace karet navrch a kdo bude hrát jen druhé housle.

Karta dostala na snímku v prezentaci přízvisko „Ultra“, které Nvidia v novodobé historii použila zatím jednou, v obdobné situaci. Totiž když se preventivně připravovala na příchod dlouho odkládaného drtiče červených pro DirectX 10 – Radeonu 2900 XT.

Vypadá to, že tak, jako si před nedávnem půjčila dovětek „Ti“ ze zlaté éry GeForce, si teď vzpomněla i na časy, kdy si vypilovanou verzí 8800 GTX s označením Ultra „posichrovala“ dlouho drženou pozici výkonnostního lídra a tímto přízviskem opatří i výkonnější modely GTX 680.

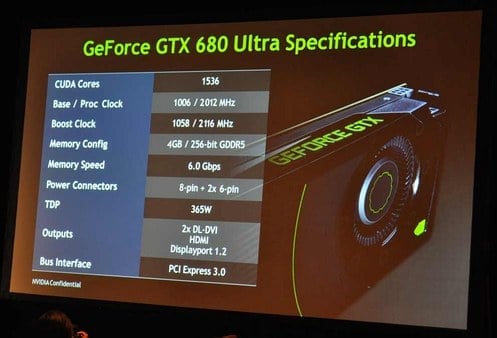

Když se podíváte na fotografii se specifikacemi, možná nebudete věřit vlastním očím, jaké eso si Nvidia schovala v rukávu:

Onou výkonnější variantou s vyšším TDP má být podle všeho tedy model, u kterého běží stream procesory na dvojnásobných taktech (tzv. hotclock) stejně jako u GeForce předcházejících generací. Co by to znamenalo pro výkon karty asi není třeba vysvětlovat.

Počet stream procesorů by měl být 1536 stejně jako u GTX 680. A stejné jsou i základní takty – 1006 MHz u jádra a 6000 MHz efektivně u pamětí typu GDDR5. Co se změnilo, jsou takty stream procesorů, které běží na 2012 (to snad ani nemůže být náhoda, to už je osud) MHz. Zároveň zůstane zachováno i „turbo“, které má kartu přetaktovávat na 1058/2116 MHz obdobně jako u předchozího modelu.

Je zřejmé, že s tak obrovským výkonem stream procesorů nebude čip zcela vyvážený a zbytek jádra a pomalejší 256b sběrnice bude výkon trochu brzdit, nakolik se ale tento hendikep promítne do praxe uvidíme až s prvními testy výkonu.

Když na spotřebě nezáleží

Při prezentaci GeForce GTX 680 Nvidia tvrdila, že hlavním problémem, kvůli kterému byla spotřeba karet s architekturou Fermi vysoká, byl dvojnásobný takt stream procesorů. U „běžné“ GTX 680 se tedy zřejmě rozhodla jít cestou navýšení počtu SP, které poběží na shodných taktech jako jádro. A teď už nikdo nepochybuje o tom, že s touto strategií slavila úspěch.

Nepochlubila se ale tím (a nejspíš záměrně), že lze i přesto hotclock aktivovat. Proč by to zatloukala? Už dlouho víme, že Radeony HD 7970 běží na podstatně nižších taktech, než jádro Tahiti zvládne. A dost je škrtí i níže taktované paměti – běží jen na 5,5 GHz, přestože jsou k dispozici i 6GHz čipy. Předpokládalo se, že po uvedení GTX 680, která je nastavená tak, aby překonávala stávající „podtaktované“ modely HD 7970, bude AMD kontrovat přetaktovanými modely, které se pomalu začínají objevovat. A GTX 680 Ultra by za těchto okolností pořádnou ranou pod pás všem posměváčkům, kteří by chtěli argumentovat tím, že HD 7970 stačí lehce přetočit a GeForce se může jít klouzat.

Vyšší takty si ale obdobně jako u starších karet Fermi vyžádají krutou daň v podobě vyšší spotřeby. U karty pro absolutní nadšence, která jde ven už s tím, že je navržená na 365 W odpadního tepla, už bude jádru GK104 vysokou spotřebu vyčítat asi jen málokdo. Spadá už do segmentu, kde se nikdo nepozastavuje ani nad 450 W, na které byly navrženy Radeony HD 6990 a má čelit přetaktovaným Radeonům, jejichž spotřeba jde s vyšším napětím jádra také razantně nahoru.

Tomuto scénáři by odpovídalo i to, že tištěný spoj karty GTX 680 je dimenzován na mnohem výkonnější napájení. Také udávaná maximální spotřeba 195 W je na highendovou kartu vysloveně směšná.

Nebo je na vině jen chyba v jádru?

Další možností (ke které se ale nikdo z Nvidie určitě nedozná) je, že již uvedená GTX 680 není postavená na plnohodnotných čipech GK104. Už před jejím uvedením se proslýchalo, že má Nvidia s GK104 problémy. Podle původních plánů měl být totiž Kepler odhalený už v lednu na CES 2012. A termín uvedení se postupně odsouval, Nvidia to dokonce nestihla ani do CeBITu a nakonec jsme se dočkali až koncem března, kdy už mělo AMD venku celou řadu HD 7000. Je možné, že Nvidia nechtěla opakovat situaci, kdy na trhu několik měsíců nerušeně vládly Radeony HD 5800 a vypustila jádro GK104, i když obsahuje nějakou chybu, kvůli které nemohou CUDA Cores běžet na plných taktech. Marketingové oddělení pak obratně vyžilo tohoto nedostatku a přetvořilo jej v pozitivum v podobě výborné spotřeby. Znamenalo by to, že GTX 680 Ultra by v takovém případě mohla nést jádro GK104 v nové revizi, u které už vše funguje, jak to mělo fungovat původně.

Dalším kamínkem zapadajícím do skládačky je kapacita osazené paměti typu GDDR5 – na GTX 680 Ultra by měly být rovnou 4 GB. O tom, že někteří výrobci připravují „Superclocked“ modely s dvojnásobkem paměti, už se taky šeptá od uvedení GTX 680. To už by dávalo smysl, 2 GB paměti, které nese standardní GTX 680, totiž opravdové highendové kartě moc nesluší – vždyť je to kapacita, se kterou se u highendu AMD rozloučilo s v minulou generací karet a nové HD 7970 už nesou 3 GB paměti a 2 GB se osazují už jen na Radeony HD 7800 z vyšší střední třídy.

Když k tomu připočtete ještě humbuk, který byl nedávno kvůli údajně připravované 2GHz kartě od Zotacu (zřejmě někdo omylem proflákl příliš dopředu něco, co neměl), začíná to všechno zapadat do sebe.

Téhle teorii by napovídalo i to, že na stránkách Zotacu ve specifikacích karet chlívek pro „hotclocks“ zůstává i u nové generace a u obyčejné GTX 680 stále (zřejmě nedopatřením) uvedená dvojnásobná frekvence stream procesorů.

Že vám připadá něco, jako je frekvence 2 GHz u (byť jen části) grafického čipu, nereálné? Není. Něco podobného už se dokonce třeba Gigabytu málem povedlo u minulé generace čipu stejné třídy (tím nemyslím cenové) u GeForce GTX 560 Ti SuperOverclock, která měla mít původně jádro taktované na 1000 MHz a stream procesory na 2000 MHz. A to šlo o kartu s jádrem na 40nm procesu. Nakonec Gigabyte u revidované karty takty kvůli problémům snížil na 950 MHz a tak stream procesory běžely „jen“ na 1900 MHz.

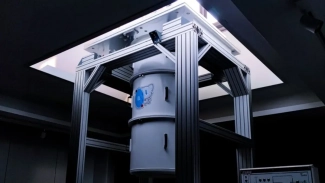

Vše podstatné ke specifikacím už zaznělo, ještě se podíváme na fotografie. Ty mají tradičně kvalitu horší než špatnou. Mizerný fotomobil a nedostatečné umělé osvětlení je ta nejhorší možná kombinace. Je opravdu zvláštní, že zatím snad ještě nikdy nikdo neměl v podobném případě s sebou normální foťák s bleskem, aby bylo vidět něco víc.

I přesto vás asi uniklé fotografie překvapí stejně jako snímek s parametry. Na fotce prototypu (ještě bez stylového potisku v nVidiácké jedovaté zelené barvě) si můžete všimnout, že má karta nějaké zvláštní proporce. A při pohledu na záslepku vám to asi docvakne:

365W šílenost od Nvidie totíž dostala tříslotové chlazení! Do podobného extrému se zatím pustil jen Asus u svých špičkových karet vybavených tříslotovou variantou chladiče DirectCU II. Už ji použil na několika modelech karet.

V místě třetí záslepky je perforace po celé délce. Výstupy pro monitory jsou podle všeho shodné s GTX 680.

Tříslotové chlazení pro špičkovou kartu se může zdát jako pitomost, hodně to totiž koplikuje osazení karet do multi-GPU. Ale v případě osazení dvou karet do SLI to s delším můstkem nebude zase takový problém a opravdoví nadšenci, kteří osazují karty do 3-way či dokonce 4-way SLI, mohou sundat záslepku i chladič a na karty posadit vodní blok a nasázet je do slotů tak, jak jsou zvyklí (ono to se třemi či čtyřmi kartami s maximální spotřebou 365 W stejně asi jinak než s vodníkem nepůjde).

Možná ještě šíleněji než chladič vypadají napájecí konektory. U standardní GTX 680 byl tištěný spoj připravený na osazení dvou šestipinů a jednoho osmipinu. Přesto byla karta osazená jen dvěma šestipiny. Nad tím, že něco podobného jsme u nejvýkonnějšího modelu nezažili už několik let, jsme se pozastavovali už v recenzi.

Na tištěném spoji GTX 680 si možná všimnete, že z dostupných kontaktů pro konektory je díky netradičnímu dvojkonektoru se šestipiny využitá jen baterie dvanácti kontaktů napravo. Původně jsem se domníval, že šestice kontaktů vlevo je tu pro případ, že bude chtít výrobce místo dvojkonektoru osadit dva šestipiny nebo kombinaci osmipinu a šestipinu. Pravda bude nejspíš někde uprostřed.

Nejen že je možné osadit různorodé kombinace přídavných konektorů, GeForce GTX 680 Ultra dokáže využít všechny kontakty beze zbytku. Tištěný spoj je tak univerzálnější, než jsme si mysleli:

Teoretická maximální spotřeba, kterou může karta osazená dvěma šestipiny a jedním osmipinem mít, činí 375 W (75 + 75 + 75 + 150 W), tedy o 10 W více, než je Nvidií udávaných maximálních 365 W. Ale to jen v rámci specifikací, ze zkušeností s Radeony HD 6990 víme, že ani to není dogma, HD 6990 měly mít podle napájecích konektorů maximální spotřebu 375 W a přesto byla typická udávaný spotřeba s OC profilem 415 W (na vlastní riziko). Ani přetaktování tedy nemusí být tabu.

V nejlepším se má přestat. Víc toho asi ze tří fotek a jednoho snímku se specifikacemi stejně nevymyslíme, nezbývá, než si počkat, až se objeví další informace. Nejvíc už nás teď bude asi zajímat reálný výkon, cena a to, kdy se nová karta opravdu objeví na trhu.

Zdroj: fórum VR-Zone